Enquanto uns conseguem aumentar o desempenho usando as regras ou por trapaça, veja a evolução do rating de Magnus Carlsen:

Depois de atingir um bom desempenho em 2015, o campeão norueguês teve uma redução no rating, chegando perto dos 2820 e bem abaixo do seu máximo. Mas o ano de 2019 tem sido glorioso para ele. Recentemente ele venceu um torneio de Zagreb, com seis empates e cinco vitórias. Em 190 dias, ele ganhou 54 partidas, empatou 55 e perdeu somente três. Os últimos oito torneios que participou, ele venceu ... oito.

Cowen, do blog Marginal Revolution, economista e ex-jogador de xadrez, afirmou que Carlsen está melhor nas aberturas que seus oponentes pela primeira vez na carreira. Mas a estratégia dele é surpreendente:

Outros grandes mestres preparam a abertura na esperança de conseguir uma vantagem antecipada sobre seus oponentes. A preparação de Magnus, em contraste, é direcionada para alcançar uma desvantagem inicial no jogo, talvez disposta a tolerar até -0,5 ou -0,6 pelos padrões do computador ... No entanto, essas são posições "fora do livro" onde Magnus, no entanto, sente que pode superar seu oponente

Ou seja, ele busca o desconhecido. É bem verdade que a opinião de Cowen não é unânime.

Mas o próprio Carlsen cita que busca a inspiração no AlphaZero, um programa desenvolvimento originalmente para jogar Go e que foi adaptado para jogar xadrez também.

25 julho 2019

Como aumentar o rating no Xadrez: lição de Rausis

A figura acima mostra a incrível evolução no rating de xadrez de Igors Rausis. Até meados de 2013 seu rating era em torno de 2500. Desde então, seu desempenho aumentou consideravelmente, chegando perto da barreira dos grandes jogadores, os 2.700 pontos. É bem verdade que o rating de xadrez rápido e blitz, onde o jogador tem menos tempo para jogar, não mudou muito nos últimos anos.

O surpreendente é que Rausis tem 58 anos de idade. Nesta idade, poucos jogadores possuem um desempenho tão expressivo. Entre os jogadores com mais de 2700 pontos, o ex-campeão Anand é o mais velho, com 49 anos. Qual o segredo de Rausis?

Duas respostas possíveis. A primeira é que ele aproveitou uma regra do xadrez para fazer pontos. Quando um jogador de melhor nível joga com um muito ruim, a regra da confederação de xadrez manda contar como se a diferença entre os jogadores fosse de 400 pontos. Se um jogador de 2500 joga com outro de 1700 (um rating de um diletante, como eu), provavelmente o jogador de 2500 irá ganhar. Só que se calcula como se a partida estivesse sendo jogada entre um jogador de 2500 versus 2100. Parece que Rausis disputou muitos torneios fracos e usou esta regra para aumentar seu rating.

A segunda explicação também ajuda a entender o bom desempenho no xadrez normal contra o xadrez mais rápido: Rausis foi pego usando um celular no banheiro. Ou seja, trapaceando. Eis uma imagem de Rausis:

Depois da notícia, um jogador chegou a afirmar nas redes sociais que não estava surpreso.

O surpreendente é que Rausis tem 58 anos de idade. Nesta idade, poucos jogadores possuem um desempenho tão expressivo. Entre os jogadores com mais de 2700 pontos, o ex-campeão Anand é o mais velho, com 49 anos. Qual o segredo de Rausis?

Duas respostas possíveis. A primeira é que ele aproveitou uma regra do xadrez para fazer pontos. Quando um jogador de melhor nível joga com um muito ruim, a regra da confederação de xadrez manda contar como se a diferença entre os jogadores fosse de 400 pontos. Se um jogador de 2500 joga com outro de 1700 (um rating de um diletante, como eu), provavelmente o jogador de 2500 irá ganhar. Só que se calcula como se a partida estivesse sendo jogada entre um jogador de 2500 versus 2100. Parece que Rausis disputou muitos torneios fracos e usou esta regra para aumentar seu rating.

A segunda explicação também ajuda a entender o bom desempenho no xadrez normal contra o xadrez mais rápido: Rausis foi pego usando um celular no banheiro. Ou seja, trapaceando. Eis uma imagem de Rausis:

Depois da notícia, um jogador chegou a afirmar nas redes sociais que não estava surpreso.

Mais um mês decepcionante no mercado de trabalho

O Ministério do Trabalho divulgou os dados do mercado de trabalho formal no Brasil para junho. Enquanto a economia teve um desempenho positivo, criando mais vagas que existiam no mês anterior, o setor contábil, que inclui os profissionais que trabalham como técnico, escriturário, contador e auditor, aconteceu o inverso. O gráfico mostra em azul o comportamento ao longo do tempo do setor contábil. Em vermelho, para fins comparativos, o desempenho da economia como um todo.

Enquanto a economia encontra-se em um processo de lenta recuperação da maior recessão da nossa história, o mesmo parece não ocorrer com a contabilidade. A distância entre as linhas está aumentando cada vez mais. Assim, a recessão continua castigando a área contábil. Mas será que é só a recessão?

A tabela mostra o comparativo entre junho de 2019 e o ano anterior. É possível perceber que nenhuma das classificações apresentadas ficaram isentas do desempenho ruim de junho.

Enquanto a economia encontra-se em um processo de lenta recuperação da maior recessão da nossa história, o mesmo parece não ocorrer com a contabilidade. A distância entre as linhas está aumentando cada vez mais. Assim, a recessão continua castigando a área contábil. Mas será que é só a recessão?

A tabela mostra o comparativo entre junho de 2019 e o ano anterior. É possível perceber que nenhuma das classificações apresentadas ficaram isentas do desempenho ruim de junho.

Viés de publicação

Ver essa foto no Instagram

Uma publicação compartilhada por Blog Contabilidade Financeira (@contabilidadefinanceira) em

Taxa de sucesso

Ver essa foto no Instagram

Uma publicação compartilhada por Blog Contabilidade Financeira (@contabilidadefinanceira) em

24 julho 2019

Qualis novo

Uma discussão para quem está envolvido em pesquisa (e ensino) foi a mudança no Qualis. O que significa isto? Como isto pode afetar a pesquisa contábil? São perguntas interessantes para serem respondidas.

Tudo começou no início dos anos 2000. Com o crescimento da pós-graduação, o governo entendeu que deveria continuar avaliando os cursos de pós-graduação. Em muitos países, isto é uma tarefa de empresas, mas no Brasil, o governo optou por construir uma avaliação para ajudá-lo na concessão de bolsas de estudos, na destinação de verbas e na autorização de funcionamento dos cursos. Um dos grandes problemas deste processo é como avaliar um curso. Muitas vezes os efeitos da educação só serão notados muitos anos depois. Para resolver isto, a avaliação da pós-graduação utiliza os resultados obtidos pelos cursos. Como geralmente estes resultados são publicados em periódicos ou congressos, esta seria uma escolha natural. A questão era como diferenciar uma pesquisa de boa qualidade de outra de baixa qualidade. Sabendo que as melhores pesquisas são publicadas sob forma de artigos em periódicos de boa fama, o governo estabeleceu que este seria o parâmetro.

No exterior, a qualidade geralmente é medida por uma variável chamada Fator de Impacto. Quando um artigo é muito citado, isto poderia indicar que a pesquisa teve uma influencia e foi importante para a sociedade. Por uma série de razões, há quase vinte anos o governo brasileiro decidiu não usar o Fator de Impacto. Quais eram estas razões? São várias as respostas: muitas áreas não publicavam regularmente, não publicavam em um idioma que fosse relevante em termos de ciência (inglês, geralmente) ou não tinham uma tradição de pesquisa. Para suprir o Fator de Impacto, o governo federal criou uma listagem de periódicos com uma classificação respectiva. No início, um especialista olhava a listagem, consultava alguns colegas e com base no seu conhecimento decidia qual nota dar para cada periódico. O processo era realmente rudimentar, mas com o tempo foi melhorando. Os editores de periódicos passaram a ter uma listagem de tarefas que conduzia uma melhoria na classificação: cadastro em algumas bases, publicação em língua estrangeira, corpo editorial de renome etc.

Existia um grau elevado de subjetividade no processo. Mas dois problemas eram notórios. O primeiro era que cada área da Capes tinha sua análise. Por exemplo, a revista Espacios, originária da Venezuela, era considerada de boa qualidade pela área de Educação e na área de História, recebendo a nota B1, a terceira maior nota de um total de oito. Mas em muitas áreas este periódico tinha nota C, a pior de todas. Além desta incoerência, cada área tinha seu critério de análise. A área de Administração Pública e de Empresas, Ciências Contábeis e Turismo tinha uma regrinha interessante: se alguém publicasse em periódico de outra área, a nota da outra área seria válida, menos um grau. Se um pesquisador de contabilidade publicasse uma pesquisa no Advances in Quantum Chemistry, que possui a classificação B3 na área de Astronomia e Física, o artigo seria considerado como equivalente a um B4, um degrau abaixo do B3. Isto fez com que a área de Administração Pública e de Empresas, Ciências Contábeis e Turismo classificasse um artigo publicado na Science, talvez o periódico de maior prestígio em termos mundiais, como sendo A2. O que é um absurdo.

Além disto, em algumas áreas existia um grande número de periódicos de “alta qualidade” (A1, A2 e B1) e em outras este número era menor. Não tínhamos uma distribuição igualitária. Na área Administração Pública e de Empresas, Ciências Contábeis e Turismo eram 323 periódicos A1, mas 427 na classe B2.

O “novo” Qualis resolveu estes dois problemas. Em primeiro lugar, a avaliação de um periódico será a mesma para qualquer área. Afinal, uma boa ciência é sempre boa independente do assunto tratado. Assim, a publicação na Science será sempre A1 (espera-se). Em segundo lugar, o número de periódicos em cada classe será o mesmo. Aqui temos uma consequência interessante: se um periódico melhorar de qualidade, deve também melhorar sua nota. Mas isto irá fazer com que um periódico melhor classificado seja rebaixado.

Como isto pode afetar a pesquisa contábil? Acredito que o novo Qualis irá fortalecer alguns periódicos, mas penalizar outros. Existe hoje uma tendência de cada IFES, cada programa de pós, ter o "seu" periódico. Isto não faz muito sentido nos dias atuais. Provavelmente os periódicos que possuem o patrocínio de mais de uma entidade sairão fortalecidos.

Tudo começou no início dos anos 2000. Com o crescimento da pós-graduação, o governo entendeu que deveria continuar avaliando os cursos de pós-graduação. Em muitos países, isto é uma tarefa de empresas, mas no Brasil, o governo optou por construir uma avaliação para ajudá-lo na concessão de bolsas de estudos, na destinação de verbas e na autorização de funcionamento dos cursos. Um dos grandes problemas deste processo é como avaliar um curso. Muitas vezes os efeitos da educação só serão notados muitos anos depois. Para resolver isto, a avaliação da pós-graduação utiliza os resultados obtidos pelos cursos. Como geralmente estes resultados são publicados em periódicos ou congressos, esta seria uma escolha natural. A questão era como diferenciar uma pesquisa de boa qualidade de outra de baixa qualidade. Sabendo que as melhores pesquisas são publicadas sob forma de artigos em periódicos de boa fama, o governo estabeleceu que este seria o parâmetro.

No exterior, a qualidade geralmente é medida por uma variável chamada Fator de Impacto. Quando um artigo é muito citado, isto poderia indicar que a pesquisa teve uma influencia e foi importante para a sociedade. Por uma série de razões, há quase vinte anos o governo brasileiro decidiu não usar o Fator de Impacto. Quais eram estas razões? São várias as respostas: muitas áreas não publicavam regularmente, não publicavam em um idioma que fosse relevante em termos de ciência (inglês, geralmente) ou não tinham uma tradição de pesquisa. Para suprir o Fator de Impacto, o governo federal criou uma listagem de periódicos com uma classificação respectiva. No início, um especialista olhava a listagem, consultava alguns colegas e com base no seu conhecimento decidia qual nota dar para cada periódico. O processo era realmente rudimentar, mas com o tempo foi melhorando. Os editores de periódicos passaram a ter uma listagem de tarefas que conduzia uma melhoria na classificação: cadastro em algumas bases, publicação em língua estrangeira, corpo editorial de renome etc.

Existia um grau elevado de subjetividade no processo. Mas dois problemas eram notórios. O primeiro era que cada área da Capes tinha sua análise. Por exemplo, a revista Espacios, originária da Venezuela, era considerada de boa qualidade pela área de Educação e na área de História, recebendo a nota B1, a terceira maior nota de um total de oito. Mas em muitas áreas este periódico tinha nota C, a pior de todas. Além desta incoerência, cada área tinha seu critério de análise. A área de Administração Pública e de Empresas, Ciências Contábeis e Turismo tinha uma regrinha interessante: se alguém publicasse em periódico de outra área, a nota da outra área seria válida, menos um grau. Se um pesquisador de contabilidade publicasse uma pesquisa no Advances in Quantum Chemistry, que possui a classificação B3 na área de Astronomia e Física, o artigo seria considerado como equivalente a um B4, um degrau abaixo do B3. Isto fez com que a área de Administração Pública e de Empresas, Ciências Contábeis e Turismo classificasse um artigo publicado na Science, talvez o periódico de maior prestígio em termos mundiais, como sendo A2. O que é um absurdo.

Além disto, em algumas áreas existia um grande número de periódicos de “alta qualidade” (A1, A2 e B1) e em outras este número era menor. Não tínhamos uma distribuição igualitária. Na área Administração Pública e de Empresas, Ciências Contábeis e Turismo eram 323 periódicos A1, mas 427 na classe B2.

O “novo” Qualis resolveu estes dois problemas. Em primeiro lugar, a avaliação de um periódico será a mesma para qualquer área. Afinal, uma boa ciência é sempre boa independente do assunto tratado. Assim, a publicação na Science será sempre A1 (espera-se). Em segundo lugar, o número de periódicos em cada classe será o mesmo. Aqui temos uma consequência interessante: se um periódico melhorar de qualidade, deve também melhorar sua nota. Mas isto irá fazer com que um periódico melhor classificado seja rebaixado.

Como isto pode afetar a pesquisa contábil? Acredito que o novo Qualis irá fortalecer alguns periódicos, mas penalizar outros. Existe hoje uma tendência de cada IFES, cada programa de pós, ter o "seu" periódico. Isto não faz muito sentido nos dias atuais. Provavelmente os periódicos que possuem o patrocínio de mais de uma entidade sairão fortalecidos.

Erros Comuns na Pesquisa

Eis alguns erros comuns quando se faz uma pesquisa, adaptado daqui:

Efeito cobra - O império Britânico queria reduzir as mortes por cobra na Índia e ofereceram um incentivo financeiro para cada pele de cobra trazida, para motivar a caça à cobra. As pessoas começaram a criar cobra. Neste caso, um incentivo para resolver um problema criou consequências negativas.

P-Hacking (ou Data Dredging) - Testes estatísticos depende da definição prévia da hipótese. Caso contrário, haveria uma "drenagem" dos dados e mudança no que está sendo testado. Para reduzir este efeito, é importante registrar antecipadamente o que está sendo testado.

Gerrymandering - A origem do termo é manipular os distritos políticos para permitir a vitória de um partido. Na figura, na parte de cima, a simples contagem mostra a vitória das pretas; mas ao dividir os "votos" em "distritos", as verdes vencem, mesmo não tendo maioria dos votos. Na análise dos dados, algumas escolhas podem afetar a conclusão, assim como a escala usada.

Reversão à média - Ocorre quando o acaso pode desempenhar um papel importante no resultado. Um jogador de futebol de baixa habilidade que marcou três gols em uma partida poderá voltar ao seu desempenho normal no próximo jogo. Um fundo de investimento que apostou certo, pode reverter a média no próximo ano.

Cherry Picking (Evidência Suprimida) - A tendência das pessoas em destacarem somente os dados que respaldam o que querem provar. Ocorre muito na política e nos debates públicos. Pode ser proposital ou não.

Efeito cobra - O império Britânico queria reduzir as mortes por cobra na Índia e ofereceram um incentivo financeiro para cada pele de cobra trazida, para motivar a caça à cobra. As pessoas começaram a criar cobra. Neste caso, um incentivo para resolver um problema criou consequências negativas.

P-Hacking (ou Data Dredging) - Testes estatísticos depende da definição prévia da hipótese. Caso contrário, haveria uma "drenagem" dos dados e mudança no que está sendo testado. Para reduzir este efeito, é importante registrar antecipadamente o que está sendo testado.

Causalidade Falsa (ou correlação espúria) - No gráfico, enquanto a temperatura na terra aumentou nos últimos anos, o número de piratas diminuiu. Isto não significa dizer que a redução dos piratas aumentou o aquecimento global. A existência de correlação não significa relação de causa-efeito.

Gerrymandering - A origem do termo é manipular os distritos políticos para permitir a vitória de um partido. Na figura, na parte de cima, a simples contagem mostra a vitória das pretas; mas ao dividir os "votos" em "distritos", as verdes vencem, mesmo não tendo maioria dos votos. Na análise dos dados, algumas escolhas podem afetar a conclusão, assim como a escala usada.

Sobre ajuste (overfitting) - Ao analisar os dados é possível obter um modelo que faça a descrição matemática. Mas um modelo muito complexo pode ajustar melhor os dados, mas são mais frágeis, pois funcionam bem com os dados usados para construir o modelo, que pode estar explicando variações aleatórias. Modelos mais simples são mais robustos e melhores para previsão.

Viés da publicação - Geralmente o estudo com resultados significantes é mais interessante de ler e mais provável de ser publicado. Quando um milionário afirma o que ele fez para vencer na vida, "esquecemos" de pessoas que fizeram as mesmas coisas, mas fracassaram.

Reversão à média - Ocorre quando o acaso pode desempenhar um papel importante no resultado. Um jogador de futebol de baixa habilidade que marcou três gols em uma partida poderá voltar ao seu desempenho normal no próximo jogo. Um fundo de investimento que apostou certo, pode reverter a média no próximo ano.

Viés de amostragem - quando as pessoas que participam de uma pesquisa não representam a população. Na figura, uma pesquisa com uma pessoa que está passeando com um cão pergunta se gosta de cão ou gato. Fazer uma pesquisa pela internet irá excluir as pessoas sem acesso a rede. Pesquisar a opinião de eleitores em um reduto conservador irá trazer um viés no resultado da pesquisa.

Paradoxo de Simpson - Uma tendência que existe em um grupo de dados pode desaparecer ou inverter quando os grupos são combinados. Na década de 70 a Universidade de Berkeley foi acusada de sexismo na seleção dos alunos. Mas ao analisar a questão descobriu que a taxa de aceitação das mulheres era maior; isto ocorreu pela diferença na escolha do curso que homem/mulher fazia.

Viés de sobrevivência - é importante saber quais os dados que não estão disponíveis. O desenho acima é um exemplo clássico que ocorreu na segunda guerra mundial. Foi solicitado aos engenheiros reforçar a fuselagem dos aviões. Olhando os aviões que voltavam das batalhas aéreas a escolha era fácil. Mas o correto é reforçar onde não tinha marca de bala - motor e cockpit - pois os aviões que foram atingidos nestes locais não voltaram.

23 julho 2019

Auditoria no Reino Unido

Segundo o The Guardian, o último relatório do Financial Reporting Council (FRC) chegou e descreve mais do mesmo. Uma em cada quatro auditorias em todo o setor, no Reino Unido, está abaixo do padrão, portanto, o desempenho não chega nem perto da meta de aceitabilidade do regulador de 90%. Nenhuma das empresas alcançou essa pontuação. A PwC substituiu a KMPG como a retardatária das Big Four, com apenas 65% de suas auditorias consideradas aceitáveis. A PwC marcou 90% recentemente, há dois anos.

O pior desempenho foi o da Grant Thornton, onde quatro das oito auditorias inspecionadas não estavam à altura. A qualidade da Grant Thornton é "inaceitável" e "uma questão de profunda preocupação", disse o FRC.

Naturalmente, todos podem divulgar um plano de ação mostrando como mais dinheiro será investido em tecnologia, pessoas e treinamento. Ano após ano, no entanto, o estudo da FRC aponta o mesmo fracasso cultural profundo: a incapacidade dos auditores em empregar o ceticismo profissional e em desafiar as suposições da administração.

A familiaridade, o regulador sugere, é um fator. Um auditor pode vir ver a empresa, e não os investidores, como “o cliente”. Até que essa mentalidade mude, é questionável se algum nível de investimento moverá o indicador de maneira significativa.

O remédio proposto pela Autoridade de Concorrência e Mercados é uma “separação operacional” entre as divisões de auditoria e consultoria das empresas. As duas metades teriam equipes de gerenciamento, contas e bônus pools separados.

Segundo Nils Pratley, editor financeiro do The Guardian, a política representaria um começo. No entanto, essa situação também exige multas que realmente doam.

Em casos particularmente cruéis, o FRC pode se incitar a impor multas de 10 milhões de libras aos auditores. Tal soma pode soar robusta, mas mal conta como pequena mudança nesta indústria. Os lucros da PwC no Reino Unido no ano passado foram de £ 935 milhões, o que permitiu que os 915 sócios ganhassem uma média de £ 712.000 cada, um aumento de 9% no ano. Os números são semelhantes em outras grandes empresas.

Fonte: Aqui, com adaptações.

O pior desempenho foi o da Grant Thornton, onde quatro das oito auditorias inspecionadas não estavam à altura. A qualidade da Grant Thornton é "inaceitável" e "uma questão de profunda preocupação", disse o FRC.

Naturalmente, todos podem divulgar um plano de ação mostrando como mais dinheiro será investido em tecnologia, pessoas e treinamento. Ano após ano, no entanto, o estudo da FRC aponta o mesmo fracasso cultural profundo: a incapacidade dos auditores em empregar o ceticismo profissional e em desafiar as suposições da administração.

A familiaridade, o regulador sugere, é um fator. Um auditor pode vir ver a empresa, e não os investidores, como “o cliente”. Até que essa mentalidade mude, é questionável se algum nível de investimento moverá o indicador de maneira significativa.

O remédio proposto pela Autoridade de Concorrência e Mercados é uma “separação operacional” entre as divisões de auditoria e consultoria das empresas. As duas metades teriam equipes de gerenciamento, contas e bônus pools separados.

Segundo Nils Pratley, editor financeiro do The Guardian, a política representaria um começo. No entanto, essa situação também exige multas que realmente doam.

Em casos particularmente cruéis, o FRC pode se incitar a impor multas de 10 milhões de libras aos auditores. Tal soma pode soar robusta, mas mal conta como pequena mudança nesta indústria. Os lucros da PwC no Reino Unido no ano passado foram de £ 935 milhões, o que permitiu que os 915 sócios ganhassem uma média de £ 712.000 cada, um aumento de 9% no ano. Os números são semelhantes em outras grandes empresas.

Fonte: Aqui, com adaptações.

Rir é o melhor remédio

Se você topar com alguém que não vê há 7 anos, todas as suas células já foram substituídas e ela/ele é algo completamente novo. Você não precisa dar oi.

22 julho 2019

Pessoas usam menos informações do que pensamos

Em um mundo onde cada vez mais temos informações em excesso, uma pesquisa mostra que usamos menos informações que imaginamos. Nadav Kleina e Ed O’Brienb, em People use less information than they think to makeup their minds, mostram isto. Eis o resumo:

A world where information is abundant promises unprecedented opportunities for information exchange. Seven studies suggestthese opportunities work better in theory than in practice: People fail to anticipate how quickly minds change, believing that they and others will evaluate more evidence before making up their minds than they and others actually do. From evaluating peers, marriage prospects, and political candidates to evaluating novel foods, goods,and services, people consume far less information than expected before deeming things good or bad. Accordingly, people acquire and share too much information in impression-formation contexts:People overvalue long-term trials, overpay for decision aids, and overwork to impress others, neglecting the speed at which conclusions will form. In today’s information age, people may intuitively believe that exchanging ever-more information will foster better-informed opinions and perspectives—but much of this informationmay be lost on minds long made up.

Novamente, a solução encontrada pelos reguladores é dar mais informação. Mas o ser humano não consegue absorver tanta coisa ao mesmo tempo. Como resolver esta equação?

A world where information is abundant promises unprecedented opportunities for information exchange. Seven studies suggestthese opportunities work better in theory than in practice: People fail to anticipate how quickly minds change, believing that they and others will evaluate more evidence before making up their minds than they and others actually do. From evaluating peers, marriage prospects, and political candidates to evaluating novel foods, goods,and services, people consume far less information than expected before deeming things good or bad. Accordingly, people acquire and share too much information in impression-formation contexts:People overvalue long-term trials, overpay for decision aids, and overwork to impress others, neglecting the speed at which conclusions will form. In today’s information age, people may intuitively believe that exchanging ever-more information will foster better-informed opinions and perspectives—but much of this informationmay be lost on minds long made up.

Novamente, a solução encontrada pelos reguladores é dar mais informação. Mas o ser humano não consegue absorver tanta coisa ao mesmo tempo. Como resolver esta equação?

China inaugura bolsa de ações de tecnologia

A euforia tomou conta com a estreia nesta segunda-feira do STAR Market, nova plataforma chinesa ao estilo Nasdaq voltada para empresas de tecnologia de origem local, com as ações disparando até 520% e os preços superando até mesmo as expectativas de investidores veteranos. A animação com a nova plataforma do mercado levou os índices tradicionais das bolsas da Ásia a caírem.

A nova plataforma ainda aumentou o valor combinado das empresas em 44 bilhões de dólares. Dezesseis da primeira leva de 25 empresas –que vão de fabricantes de chips a empresas de saúde — mais do que dobraram os já fortes preços de oferta pública inicial de ações (IPO) no STAR Market, que é operado pela bolsa de Xangai.

As empresas registraram ganhos médios de 140% no primeiro dia de negociações. O desempenho mais fraco foi um salto de 84,22%.

No total, o dia teve criação de cerca de 305 bilhões de iuanes (44,3 bilhões de dólares) em nova capitalização de mercado, de acordo com cálculos da Reuters.

“Os ganhos de preços são mais loucos do que esperávamos”, disse Stephen Huang, vice-presidente da Shanghai See Truth Investment Management. “São boas empresas, mas os valores são altos demais. Comprá-las agora não faz sentido.”

Com base no Nasdaq e completo com um sistema de IPOs ao estilo dos EUA, o STAR pode ser a tentativa mais ousada da China de reformas no mercado de capital até agora. (...)

Fonte: Aqui

A nova plataforma ainda aumentou o valor combinado das empresas em 44 bilhões de dólares. Dezesseis da primeira leva de 25 empresas –que vão de fabricantes de chips a empresas de saúde — mais do que dobraram os já fortes preços de oferta pública inicial de ações (IPO) no STAR Market, que é operado pela bolsa de Xangai.

As empresas registraram ganhos médios de 140% no primeiro dia de negociações. O desempenho mais fraco foi um salto de 84,22%.

No total, o dia teve criação de cerca de 305 bilhões de iuanes (44,3 bilhões de dólares) em nova capitalização de mercado, de acordo com cálculos da Reuters.

“Os ganhos de preços são mais loucos do que esperávamos”, disse Stephen Huang, vice-presidente da Shanghai See Truth Investment Management. “São boas empresas, mas os valores são altos demais. Comprá-las agora não faz sentido.”

Com base no Nasdaq e completo com um sistema de IPOs ao estilo dos EUA, o STAR pode ser a tentativa mais ousada da China de reformas no mercado de capital até agora. (...)

Fonte: Aqui

Origem do cifrão

Também conhecido como sinal ou símbolo de dólar, hoje é ligado ao consumismo e à mercantilização. Significa ao mesmo uma tempo ambição ensolarada, a ganância turbulenta e o capitalismo desenfreado. (...)

No entanto, apesar de sua onipresença, sua origem permanece longe de ser clara, com teorias concorrentes que falam em moedas da Boêmia, nos Pilares de Hércules e mercadores atormentados.

Muitas pessoas acreditam que é um "S" sobreposto por um "U" espremido e sem dobra. Na verdade, um dos equívocos mais comuns sobre a origem do cifrão é que ele significa "United States" (Estados Unidos, em inglês).(...)

No entanto, não há uma resposta direta para a questão de onde surgiu o cifrão. Ninguém parece ter se sentado para projetá-lo, e sua forma ainda varia - às vezes, tem duas barras, mas, cada vez mais, apenas uma.

Não que não haja muitas hipóteses diferentes. Por exemplo, voltando à ideia de que há um "U" e um "S" escondidos em sua forma, se sugere que eles representam "units of silver" (unidades de prata, em inglês).

Uma das teorias mais esotéricas o liga ao thaler da Boémia, que apresentava uma serpente numa cruz cristã. Este em si foi uma alusão à história de Moisés enrolando uma cobra de bronze em torno de um bastão para curar pessoas que foram mordidas. O dólar, por assim dizer, seria derivado disso.

Outra versão centra-se nos Pilares de Hércules, termo usado pelos gregos antigos para descrever os penhascos na entrada do estreito de Gibraltar.

Os pilares aparecem no brasão nacional da Espanha e, durante os séculos 18 e 19, apareceram no dólar espanhol, que era conhecido como "peso de ocho reales", ou simplesmente "peso". Os pilares têm bandeiras enroladas em torno deles em forma de "S" e não é preciso se esforçar muito para ver ali uma semelhança com o cifrão.

A teoria mais aceita envolve a cunhagem espanhola: nas colônias, o comércio entre os hispano-americanos e os ingleses-americanos era intenso, e o peso era legal nos Estados Unidos até 1857.

Foi com frequência abreviado, dizem os historiadores, para a inicial "P" com um "S" pairando ao lado dele sobrescrito. Gradualmente, graças ao rabisco de comerciantes e escribas pressionados pelo tempo, aquele "P" fundiu-se com o "S" e perdeu sua curva, deixando o traço vertical no centro do "S".

Um dólar espanhol valia mais ou menos um dólar americano, então, é fácil ver como o sinal pode ter sido adotado.

Como em tudo que é ligado aos Estados Unidos no momento, há uma dimensão partidária no debate sobre a origem do cifrão: por razões políticas, uma facção favorece a ideia de que é doméstica, outra que foi importada.

Independentemente de como tenha sido, certamente é uma invenção americana: uma correspondência do irlandês Oliver Pollock, um rico comerciante e antigo defensor da Revolução Americana, fez com que ele seja frequentemente citado pelos historiadores como seu criador.

E o primeiro cifrão impresso, feito em uma impressora na década de 1790, foi o trabalho de um americano patriota - ou pelo menos um veementemente anti-inglês - chamado Archibald Binny, que é hoje lembrado como o criador do tipo de letra Monticello.

Fonte: Aqui

No entanto, apesar de sua onipresença, sua origem permanece longe de ser clara, com teorias concorrentes que falam em moedas da Boêmia, nos Pilares de Hércules e mercadores atormentados.

Muitas pessoas acreditam que é um "S" sobreposto por um "U" espremido e sem dobra. Na verdade, um dos equívocos mais comuns sobre a origem do cifrão é que ele significa "United States" (Estados Unidos, em inglês).(...)

No entanto, não há uma resposta direta para a questão de onde surgiu o cifrão. Ninguém parece ter se sentado para projetá-lo, e sua forma ainda varia - às vezes, tem duas barras, mas, cada vez mais, apenas uma.

Não que não haja muitas hipóteses diferentes. Por exemplo, voltando à ideia de que há um "U" e um "S" escondidos em sua forma, se sugere que eles representam "units of silver" (unidades de prata, em inglês).

Uma das teorias mais esotéricas o liga ao thaler da Boémia, que apresentava uma serpente numa cruz cristã. Este em si foi uma alusão à história de Moisés enrolando uma cobra de bronze em torno de um bastão para curar pessoas que foram mordidas. O dólar, por assim dizer, seria derivado disso.

Outra versão centra-se nos Pilares de Hércules, termo usado pelos gregos antigos para descrever os penhascos na entrada do estreito de Gibraltar.

Os pilares aparecem no brasão nacional da Espanha e, durante os séculos 18 e 19, apareceram no dólar espanhol, que era conhecido como "peso de ocho reales", ou simplesmente "peso". Os pilares têm bandeiras enroladas em torno deles em forma de "S" e não é preciso se esforçar muito para ver ali uma semelhança com o cifrão.

A teoria mais aceita envolve a cunhagem espanhola: nas colônias, o comércio entre os hispano-americanos e os ingleses-americanos era intenso, e o peso era legal nos Estados Unidos até 1857.

Foi com frequência abreviado, dizem os historiadores, para a inicial "P" com um "S" pairando ao lado dele sobrescrito. Gradualmente, graças ao rabisco de comerciantes e escribas pressionados pelo tempo, aquele "P" fundiu-se com o "S" e perdeu sua curva, deixando o traço vertical no centro do "S".

Um dólar espanhol valia mais ou menos um dólar americano, então, é fácil ver como o sinal pode ter sido adotado.

Como em tudo que é ligado aos Estados Unidos no momento, há uma dimensão partidária no debate sobre a origem do cifrão: por razões políticas, uma facção favorece a ideia de que é doméstica, outra que foi importada.

Independentemente de como tenha sido, certamente é uma invenção americana: uma correspondência do irlandês Oliver Pollock, um rico comerciante e antigo defensor da Revolução Americana, fez com que ele seja frequentemente citado pelos historiadores como seu criador.

E o primeiro cifrão impresso, feito em uma impressora na década de 1790, foi o trabalho de um americano patriota - ou pelo menos um veementemente anti-inglês - chamado Archibald Binny, que é hoje lembrado como o criador do tipo de letra Monticello.

Fonte: Aqui

21 julho 2019

Neuralink irá conectar cérebros diretamente com a internet

Uma das empresas do multi-empresário Elon Musk, a Neuralink, está trabalhando em uma tecnologia inovadora baseada em “fios” ou eletrodos que serão implantados no cérebro humano.

O objetivo de tal tecnologia? Conectar nossos cérebros a potenciais interfaces computacionais, como a internet. Por enquanto, os fios ultrafinos serão testados para fins médicos, mas a longo prazo a ideia é “alcançar uma espécie de simbiose com a inteligência artificial”. (...)

A Neuralink foi fundada em 2017 e é presidida por Max Hodak. A tecnologia para “hackear” cérebros humanos ainda está em estágio inicial, e há um longo caminho pela frente antes que possa ser comercializada.

Por enquanto, o plano é usar robôs para operar uma espécie de “máquina de costura” a fim de implantar os fios (que tem aproximadamente um terço do diâmetro de um fino cabelo humano) no tecido cerebral de uma pessoa, onde serão capazes de realizar operações de leitura e escrita de informações em grandes volumes de dados.

No futuro, o método deve evoluir para o uso de lasers que farão minúsculos buracos no crânio humano para implantar os fios ultrafinos. Isso seria muito menos invasivo e os pacientes não sentiriam nada. Os eletrodos podem teoricamente ser utilizados para propósitos médicos, como permitir que amputados reganhem mobilidade através de membros protéticos, ou restaurar visão e audição, por exemplo. Esse tipo de teste pode começar já no ano que vem, inclusive.

A Neuralink demonstrou a tecnologia em ratos em laboratório recentemente, e a performance excedeu os melhores sistemas de interface cérebro-computador que existem hoje. Os dados foram recolhidos via USB-C e geraram cerca de dez vezes mais transferência de informação do que os melhores sensores atuais. Por enquanto, a fim de avançar na pesquisa, a Neuralink está recrutando talentos e divulgando suas descobertas justamente para poder trabalhar mais abertamente esse campo de estudo, alcançando melhores resultados.

Por exemplo, existe a questão sobre a longevidade dos fios/eletrodos quando expostos ao cérebro humano, uma vez que o órgão possui uma mistura salina que pode danificar e degradar plásticos ao longo do tempo. Em última análise, o plano é que os eletrodos implantados sejam capazes de se comunicar com chips fora do cérebro sem necessidade de nenhuma conexão, proporcionando monitoramento em tempo real e com liberdade de movimento sem precedentes.

Fonte: Aqui

O objetivo de tal tecnologia? Conectar nossos cérebros a potenciais interfaces computacionais, como a internet. Por enquanto, os fios ultrafinos serão testados para fins médicos, mas a longo prazo a ideia é “alcançar uma espécie de simbiose com a inteligência artificial”. (...)

A Neuralink foi fundada em 2017 e é presidida por Max Hodak. A tecnologia para “hackear” cérebros humanos ainda está em estágio inicial, e há um longo caminho pela frente antes que possa ser comercializada.

Por enquanto, o plano é usar robôs para operar uma espécie de “máquina de costura” a fim de implantar os fios (que tem aproximadamente um terço do diâmetro de um fino cabelo humano) no tecido cerebral de uma pessoa, onde serão capazes de realizar operações de leitura e escrita de informações em grandes volumes de dados.

No futuro, o método deve evoluir para o uso de lasers que farão minúsculos buracos no crânio humano para implantar os fios ultrafinos. Isso seria muito menos invasivo e os pacientes não sentiriam nada. Os eletrodos podem teoricamente ser utilizados para propósitos médicos, como permitir que amputados reganhem mobilidade através de membros protéticos, ou restaurar visão e audição, por exemplo. Esse tipo de teste pode começar já no ano que vem, inclusive.

A Neuralink demonstrou a tecnologia em ratos em laboratório recentemente, e a performance excedeu os melhores sistemas de interface cérebro-computador que existem hoje. Os dados foram recolhidos via USB-C e geraram cerca de dez vezes mais transferência de informação do que os melhores sensores atuais. Por enquanto, a fim de avançar na pesquisa, a Neuralink está recrutando talentos e divulgando suas descobertas justamente para poder trabalhar mais abertamente esse campo de estudo, alcançando melhores resultados.

Por exemplo, existe a questão sobre a longevidade dos fios/eletrodos quando expostos ao cérebro humano, uma vez que o órgão possui uma mistura salina que pode danificar e degradar plásticos ao longo do tempo. Em última análise, o plano é que os eletrodos implantados sejam capazes de se comunicar com chips fora do cérebro sem necessidade de nenhuma conexão, proporcionando monitoramento em tempo real e com liberdade de movimento sem precedentes.

Fonte: Aqui

20 julho 2019

Por que tentar melhorar?

Tenho curtido este canal do Craig Benzine, o Wheezy Waiter. Ele posta alguns vídeos nos quais fala de uma forma peculiar, nerd e leve sobre ter passado um mês fazendo algo diferente... Como quando abriu mão da internet, se tornou vegano, manteve uma boa postura ou ficou sem açúcar. Neste ele troca algumas ideias sobre constante autoaperfeiçoamento... Há legendas em inglês.

19 julho 2019

Amazon investigada pela União Europeia

A Comissão Europeia anunciou nesta quarta-feira (17) a abertura de uma investigação sobre o uso de dados comerciais pela Amazon através de sua plataforma "Marketplace", para determinar se a empresa infringe as regras europeias de concorrência.

O objetivo é "determinar se a Amazon usa dados confidenciais de varejistas independentes", que vendem seus produtos no "Marketplace", onde a Amazon também comercializa os seus próprios, e se "viola as regras de concorrência da UE", disse a Comissão.

Bruxelas suspeita que a empresa americana se beneficie de um "duplo papel como plataforma".

A Amazon vende seus produtos em seu site como varejista e, além disso, disponibiliza espaços para vendedores independentes em sua plataforma de vendas digitais para oferecer seus produtos aos consumidores.

As primeiras investigações da Comissão revelaram que "a Amazon usa informações sensíveis do ponto de vista da concorrência que afetam os vendedores do 'Marketplace', seus produtos e suas transações". Por isso, decidiram abrir uma investigação em profundidade.

A investigação buscará determinar se as regras em acordos fechados entre a empresa de comércio eletrônico e os varejistas são respeitadas, bem como o papel dos dados de seleção de vencedores da "Buy Box", uma seção essencial para os varejistas.

"O comércio eletrônico estimulou a concorrência no varejo, expandiu a oferta e reduziu os preços", disse Margrethe Vestager, comissária de concorrência, assegurando que eles buscam impedir o desaparecimento desses benefícios por meio de práticas anticompetitivas.

A gigante americana está no centro das atenções de outras investigações feitas por autoridades de concorrência na Áustria, em Luxemburgo e na Itália, embora elas "não se sobreponham" à que foi anunciado na quarta-feira, de acordo com uma porta-voz da Comissão Européia. (...)

Fonte: Aqui

O objetivo é "determinar se a Amazon usa dados confidenciais de varejistas independentes", que vendem seus produtos no "Marketplace", onde a Amazon também comercializa os seus próprios, e se "viola as regras de concorrência da UE", disse a Comissão.

Bruxelas suspeita que a empresa americana se beneficie de um "duplo papel como plataforma".

A Amazon vende seus produtos em seu site como varejista e, além disso, disponibiliza espaços para vendedores independentes em sua plataforma de vendas digitais para oferecer seus produtos aos consumidores.

As primeiras investigações da Comissão revelaram que "a Amazon usa informações sensíveis do ponto de vista da concorrência que afetam os vendedores do 'Marketplace', seus produtos e suas transações". Por isso, decidiram abrir uma investigação em profundidade.

A investigação buscará determinar se as regras em acordos fechados entre a empresa de comércio eletrônico e os varejistas são respeitadas, bem como o papel dos dados de seleção de vencedores da "Buy Box", uma seção essencial para os varejistas.

"O comércio eletrônico estimulou a concorrência no varejo, expandiu a oferta e reduziu os preços", disse Margrethe Vestager, comissária de concorrência, assegurando que eles buscam impedir o desaparecimento desses benefícios por meio de práticas anticompetitivas.

A gigante americana está no centro das atenções de outras investigações feitas por autoridades de concorrência na Áustria, em Luxemburgo e na Itália, embora elas "não se sobreponham" à que foi anunciado na quarta-feira, de acordo com uma porta-voz da Comissão Européia. (...)

Fonte: Aqui

Carlos Ghosn abre processo contra Nissan e Mitsubishi Motors

O ex-presidente da montadora francesa Renault,(...) Carlos Ghosn, entrou com uma ação contra as empresas japonesas Nissan e Mitsubishi Motors por violação abusiva de seu contrato em uma empresa com sede na Holanda. (...) O ex-CEO da Renault e da Nissan pede 15 milhões de euros (16,8 milhões de dólares) a título de indenização.

Fundada em 2017 para explorar as sinergias entre os dois grupos, a subsidiária Nissan-Mitsubishi B.V. (NMBV) foi dissolvida em março de 2019, após a prisão de Carlos Ghosn no Japão por suspeita de fraude financeira.

A Nissan e a Mitsubishi Motors disseram em janeiro que Ghosn havia recebido como administrador do NMBV “uma remuneração total de 7.822.206,12 euros”.

Segundo a Nissan, que quer recuperar o montante indevidamente recebido, Ghosn fez um contrato por conta própria em 2018, “sem discutir com os outros membros do conselho de administração da NMBV”, no caso os presidentes da Nissan, Hiroto Saikawa, e da Mitsubishi Motors, Osamu Masuko.

Fonte: Aqui. Leia mais sobre Ghosn: Aqui.

Fundada em 2017 para explorar as sinergias entre os dois grupos, a subsidiária Nissan-Mitsubishi B.V. (NMBV) foi dissolvida em março de 2019, após a prisão de Carlos Ghosn no Japão por suspeita de fraude financeira.

A Nissan e a Mitsubishi Motors disseram em janeiro que Ghosn havia recebido como administrador do NMBV “uma remuneração total de 7.822.206,12 euros”.

Segundo a Nissan, que quer recuperar o montante indevidamente recebido, Ghosn fez um contrato por conta própria em 2018, “sem discutir com os outros membros do conselho de administração da NMBV”, no caso os presidentes da Nissan, Hiroto Saikawa, e da Mitsubishi Motors, Osamu Masuko.

Fonte: Aqui. Leia mais sobre Ghosn: Aqui.

Tesouro defende o projeto da nova lei de finanças públicas

|

| Fonte da imagem: aqui |

"O orçamento é a peça mais importante da democracia. É o Congresso que dá a palavra final do que será o país e de quais são os planos mais importantes", disse o secretário Mansueto Almeida em sua apresentação. "Mas estamos presos a uma lei de 1964 e de lá para cá houve muitas mudanças e avanços na área da contabilidade. É preciso modernizar essa lei e aumentar o controle que o Congresso vai ter sobre as finanças públicas em todo o processo orçamentário", disse ele.

O secretário apontou, por exemplo, que a lei atualmente vigente é focada demais em receita e despesa no exercício financeiro. O normativo proposto permitiria, segundo ele, um maior acompanhamento e controle de outros pontos que também são importantes, como ativos e passivos, além de lançar luz sobre alguns pontos cegos, como os fundos públicos. "Hoje perdemos o controle do número e do valor dos funcos públicos existentes", disse Mansueto. O projeto também propõe regras para os restos a pagar. "No ano passado, o Tesouro pagou restos a pagar de 2010", afirmou ele.

Para Mansueto, o projeto é um marco fundamental nesse desejo da sociedade por mais transparência e mais previsibilidade das contas no médio e longo prazo.

Fonte: Aqui

17 julho 2019

Imposto Único: uma grande bobagem

Excelente discussão sobre imposto único e reforma tributária no Brasil:

16 julho 2019

Concentração e Mudança Tecnológica

Hsieh e Rossi-Hansberg estudaram o setor de serviço nos Estados Unidos entre 1977 a 2013. Eles verificaram se a nova revolução industrial em setores de serviço provocou algum aumento na concentração nas empresas.

O interessante na abordagem dos autores é que usam a estrutura de custo - em particular a participação dos novos custos fixos tecnológicos - para procurar entender a concentração no setor. A conclusão dos autores é que a concentração não apresentou mudança substancial - nem aumento, nem redução - durante o período analisado.

Mas será que isto é válido para a contabilidade? Sendo uma atividade de serviço, também não deveria existir um aumento na concentração. É importante notar que a questão da concentração é bastante complexa. Bonfigliogi, Crinò e Gancia mostraram que as transações de empresas multinacionais podem afetar este valor. Rossi-Hansberg e outros indicaram que a concentração nacional parece aumentar, enquanto a concentração local indica uma redução.

E a contabilidade? A questão da concentração é uma preocupação bastante presente entre as empresas de auditoria. Este assunto é bastante pesquisado na literatura, como em Dantas, Medeiros e Paulo, em 2011. Entretanto, no escritório de contabilidade não sabemos ao certo se a concentração está aumentando ou não. No caso da contabilidade, muitas vezes é uma atividade "terceirizada" e isto pode afetar a concentração. Dois outros fatores podem afetar esta concentração: a mudança tecnológica (vide Hsieh e Hansberg) afetando a estrutura de custo e a mudança de legislação, como a criação do MEI.

Recentemente, Souza, Silva, Silva e Souza (é isto mesmo) analisaram a concentração dos profissionais de contabilidade em termos geográficos. Sabemos que cidades com mais habitantes possuem mais profissionais, mas os autores mostraram que quando se analisa em termos proporcionais, a concentração é afetada por um fator: o desenvolvimento humano do local.

The Industrial Revolution in Services - Chang-Tai Hsieh, Esteban Rossi-Hansberg - NBER Working Paper No. 25968 - Issued in June 2019

Bonfiglioli, A, R Crinò and G Gancia (2019), "Concentration in international markets: Evidence from US imports," CEPR Discussion paper 13566.

Diverging Trends in National and Concentration - Esteban Rossi-Hansberg, Pierre-Daniel Sarte, Nicholas Trachter. NBER Working Paper No. 25066. Issued in September 2018

DANTAS, José Alves; DE MEDEIROS, Otávio Ribeiro; PAULO, Edilson. Relação entre concentração e rentabilidade no setor bancário brasileiro. Revista Contabilidade Finanças, v. 22, n. 55, p. 5-28, 2011.

O interessante na abordagem dos autores é que usam a estrutura de custo - em particular a participação dos novos custos fixos tecnológicos - para procurar entender a concentração no setor. A conclusão dos autores é que a concentração não apresentou mudança substancial - nem aumento, nem redução - durante o período analisado.

Mas será que isto é válido para a contabilidade? Sendo uma atividade de serviço, também não deveria existir um aumento na concentração. É importante notar que a questão da concentração é bastante complexa. Bonfigliogi, Crinò e Gancia mostraram que as transações de empresas multinacionais podem afetar este valor. Rossi-Hansberg e outros indicaram que a concentração nacional parece aumentar, enquanto a concentração local indica uma redução.

E a contabilidade? A questão da concentração é uma preocupação bastante presente entre as empresas de auditoria. Este assunto é bastante pesquisado na literatura, como em Dantas, Medeiros e Paulo, em 2011. Entretanto, no escritório de contabilidade não sabemos ao certo se a concentração está aumentando ou não. No caso da contabilidade, muitas vezes é uma atividade "terceirizada" e isto pode afetar a concentração. Dois outros fatores podem afetar esta concentração: a mudança tecnológica (vide Hsieh e Hansberg) afetando a estrutura de custo e a mudança de legislação, como a criação do MEI.

Recentemente, Souza, Silva, Silva e Souza (é isto mesmo) analisaram a concentração dos profissionais de contabilidade em termos geográficos. Sabemos que cidades com mais habitantes possuem mais profissionais, mas os autores mostraram que quando se analisa em termos proporcionais, a concentração é afetada por um fator: o desenvolvimento humano do local.

The Industrial Revolution in Services - Chang-Tai Hsieh, Esteban Rossi-Hansberg - NBER Working Paper No. 25968 - Issued in June 2019

Bonfiglioli, A, R Crinò and G Gancia (2019), "Concentration in international markets: Evidence from US imports," CEPR Discussion paper 13566.

Diverging Trends in National and Concentration - Esteban Rossi-Hansberg, Pierre-Daniel Sarte, Nicholas Trachter. NBER Working Paper No. 25066. Issued in September 2018

DANTAS, José Alves; DE MEDEIROS, Otávio Ribeiro; PAULO, Edilson. Relação entre concentração e rentabilidade no setor bancário brasileiro. Revista Contabilidade Finanças, v. 22, n. 55, p. 5-28, 2011.

15 julho 2019

Turing na nota de 50 libras

Alan Turing irá aparecer na nova nota de 50 libras do Bank of England. Turing foi responsável pela quebra do código dos nazistas durante a segunda guerra mundial. A nota deve entrar em circulação em 2021.

Alan Turing irá aparecer na nova nota de 50 libras do Bank of England. Turing foi responsável pela quebra do código dos nazistas durante a segunda guerra mundial. A nota deve entrar em circulação em 2021. Turing foi um matemático e considerado o pai da computação e da inteligência artificial. Durante a guerra, Turing ajudou a quebrar o código do Enigma, a máquina de código dos alemães. Mas em 1952 foi condenado por indecência, por ter um caso com um homem, sendo castrado quimicamente. Somente em 2013 recebeu o perdão real.

Quando pensou em lançar uma homenagem a um cientista, o Banco da Inglaterra recebeu 227 mil indicações. Entre os finalistas: Mary Anning, Paul Dirac, Rosalind Franklin, William Herschel e Caroline Herschel, Dorothy Hodgkin, Ada Lovelace e Charles Babbage, Stephen Hawking, James Clerk Maxwell, Srinivasa Ramanujan, Ernest Rutherford, Frederick Sanger e Alan Turing.

14 julho 2019

Falência do Lehman Brothers: o papel da E&Y

Resumo:

For many years prior to its demise, Lehman Brothers employed Ernst & Young (EY) as the firm’s independent auditors to review its financial statements and express an opinion as to whether they fairly represented the company’s financial position. EY was supposed to try to detect fraud, determine whether a matter should be publicly disclosed, and communicate certain issues to Lehman’s Board audit committee. After Lehman filed for bankruptcy, it was discovered that the firm had employed questionable accounting with regard to an unorthodox financing transaction, Repo 105, which it used to make its results appear better than they were. EY was aware of Lehman’s use of Repo 105, and its failure to disclose its use. EY also knew that Lehman included in its liquidity pool assets that were impaired. When questioned, EY insisted that it had done nothing wrong. However, Anton R. Valukas, the Lehman bankruptcy examiner, concluded that EY had not fulfilled its duties and that probable claims existed against EY for malpractice. In this case, participants will consider the role and effectiveness of independent auditors in ensuring complete and accurate financial statements and related public disclosure.

Fonte:

Wiggins, Rosalind Z.; Bennett, Rosalind L.; and Metrick, Andrew (2019) "The Lehman Brothers Bankruptcy D: The Role of Ernst & Young," Journal of Financial Crises: Vol. 1 : Iss. 1, 100-123.

For many years prior to its demise, Lehman Brothers employed Ernst & Young (EY) as the firm’s independent auditors to review its financial statements and express an opinion as to whether they fairly represented the company’s financial position. EY was supposed to try to detect fraud, determine whether a matter should be publicly disclosed, and communicate certain issues to Lehman’s Board audit committee. After Lehman filed for bankruptcy, it was discovered that the firm had employed questionable accounting with regard to an unorthodox financing transaction, Repo 105, which it used to make its results appear better than they were. EY was aware of Lehman’s use of Repo 105, and its failure to disclose its use. EY also knew that Lehman included in its liquidity pool assets that were impaired. When questioned, EY insisted that it had done nothing wrong. However, Anton R. Valukas, the Lehman bankruptcy examiner, concluded that EY had not fulfilled its duties and that probable claims existed against EY for malpractice. In this case, participants will consider the role and effectiveness of independent auditors in ensuring complete and accurate financial statements and related public disclosure.

Fonte:

Wiggins, Rosalind Z.; Bennett, Rosalind L.; and Metrick, Andrew (2019) "The Lehman Brothers Bankruptcy D: The Role of Ernst & Young," Journal of Financial Crises: Vol. 1 : Iss. 1, 100-123.

13 julho 2019

Teoria e Efeito causal

Em fevereiro, Stefan Szymanski publicou um texto no site Soccernomics chamado "Soccer Analytics: Science or Alchemy?". Ele trata de muitos temas: previsão no futebol, aumento no número de dados, modelos com muitas variáveis, teoria a partir dos dados, etc. Vários dos aspectos foram tratados no blog nos últimos anos.

No final ele apresenta quatro pontos:

(1) Theories are useful because they help us to identify causal effects. Big data approaches in soccer seem largely to avoid theorizing, which risks reducing the analysis simply to the search for correlations. I don’t think any science can prosper if straightjacketed in this way.

(2) In natural science causal effects are usually tested using controlled experiments. Social science relies on observational data, which makes the identification of causality much more difficult. There have been huge advances in our understanding of how to identify causality through statistical methods over the last three decades, but as yet I’ve seen little recognition of the issue in soccer analytics papers.

(3)There is a financial profit to be made in soccer analytics. Mostly this is not about beating the bookies but advising clubs on identification of strategies, playing talent and so on. This world closely resembles the world of alchemy- it is secretive and given to obscure utterings. Results are announced but not explained, success is claimed but not proven. This is perhaps inevitable as long as the potential for profit exists. There are also such non-scientific analyses of the stock market, together with promises of untold returns. The only cure for this a healthy skepticism.

(4) In the end, I believe, soccer analytics will be judged on its capacity to predict. I have outlined some of the challenges to developing predictions in relation to game results, but there are potentially other areas where soccer analytics can contribute, involving outcome related to specific on-field events.

No final ele apresenta quatro pontos:

(1) Theories are useful because they help us to identify causal effects. Big data approaches in soccer seem largely to avoid theorizing, which risks reducing the analysis simply to the search for correlations. I don’t think any science can prosper if straightjacketed in this way.

(2) In natural science causal effects are usually tested using controlled experiments. Social science relies on observational data, which makes the identification of causality much more difficult. There have been huge advances in our understanding of how to identify causality through statistical methods over the last three decades, but as yet I’ve seen little recognition of the issue in soccer analytics papers.

(3)There is a financial profit to be made in soccer analytics. Mostly this is not about beating the bookies but advising clubs on identification of strategies, playing talent and so on. This world closely resembles the world of alchemy- it is secretive and given to obscure utterings. Results are announced but not explained, success is claimed but not proven. This is perhaps inevitable as long as the potential for profit exists. There are also such non-scientific analyses of the stock market, together with promises of untold returns. The only cure for this a healthy skepticism.

(4) In the end, I believe, soccer analytics will be judged on its capacity to predict. I have outlined some of the challenges to developing predictions in relation to game results, but there are potentially other areas where soccer analytics can contribute, involving outcome related to specific on-field events.

Índice de Sharpe esconde riscos

O gráfico abaixo mostra no eixo X o índice de Sharpe para 3098 fundos de hedge de Janeiro de 2004 a 2007 e no eixo Y suas perdas medidas pelo desvio-padrão após a crise de 2008. Os fundos menos voláteis tiveram as maiores perdas. Quanto mais estável o retorno, maior a chance de perdas. Ou seja,o índice sharpe não consegue prever desempenho futuro e não prevê perdas durante crises. Ele não funciona out-of-sample (fora da amostra)

Fonte: aqui

12 julho 2019

Leasing, IFRS 16 e Portugal

Um artigo de um jornal português sobre a norma de Leasing.

A IFRS 16 – Locações entrou em vigor a 1 de janeiro de 2019 e teve os seus reflexos na publicação das contas das empresas no primeiro trimestre do ano. Segundo alguns analistas o objetivo da norma não foi totalmente atingido. Qual a razão para que tal tenha acontecido?

A IFRS 16 requere que os locatários contabilizem todas as locações (“operacionais” e “financeiras) com base num modelo único de reconhecimento no balanço. Assim, na data de início da locação, o locatário reconhece a responsabilidade relacionada com os pagamentos da locação e o ativo que representa o direito a usar o bem subjacente (ROU), durante o período da locação.

Simultaneamente, é reconhecido o custo do juro sobre o passivo da locação e a respetiva amortização do ROU. O objetivo pretendido com a norma seria permitir a comparabilidade: i) das demonstrações financeiras através do registo em balanço de todos os ativos e passivos das locações, independentemente da forma de detenção dos ativos e do seu financiamento; e ii) dos indicadores de performance das empresas (KPI’s).

Da análise das contas do primeiro trimestre das principais operadoras de telecomunicações europeias, pode concluir-se que os maiores impactos da aplicação da referida norma, resultam do registo em balanço dos contratos de arrendamento de infraestruturas (sites) de rede móvel e rede fixa, lojas, edifícios, data centres e da apresentação em resultados da amortização do ROU e dos juros do passivo da locação. Simultaneamente, verifica-se que alguns KPI’s anteriormente usados para a avaliação da performance das empresas e acompanhados pelos stakeholders, foram agora significativamente alterados, dificultando a comparabilidade das empresas do setor, no que se refere à análise do grau de alavancagem e da avaliação das empresas. Como consequência e exemplo, algumas empresas passaram a apresentar o EBITDA AL (EBITDA After Leases), um novo KPI que difere significativamente do atual EBITDA, agora sem os gastos de arrendamentos e juros, ou seja, de montante significativamente superior ao EBITDA AL. Será o início do regresso ao passado e dar-se-á a substituição deste KPI pelo Cash Flow?

Apesar das Normas Internacionais de Contabilidade pretenderem a harmonização das informações financeiras apresentadas pelos emissores de valores mobiliários na União Europeia e garantir uma maior transparência e comparabilidade, é necessário a definição de um modelo “único” de divulgação das contas ao mercado e dos KPI’s apresentados, de modo a que uma nova norma, como a IFRS16, não prejudique a comparabilidade das empresas do setor.

Jornal Econômico (Portugal) - Jessica Pereira

A IFRS 16 – Locações entrou em vigor a 1 de janeiro de 2019 e teve os seus reflexos na publicação das contas das empresas no primeiro trimestre do ano. Segundo alguns analistas o objetivo da norma não foi totalmente atingido. Qual a razão para que tal tenha acontecido?

A IFRS 16 requere que os locatários contabilizem todas as locações (“operacionais” e “financeiras) com base num modelo único de reconhecimento no balanço. Assim, na data de início da locação, o locatário reconhece a responsabilidade relacionada com os pagamentos da locação e o ativo que representa o direito a usar o bem subjacente (ROU), durante o período da locação.

Simultaneamente, é reconhecido o custo do juro sobre o passivo da locação e a respetiva amortização do ROU. O objetivo pretendido com a norma seria permitir a comparabilidade: i) das demonstrações financeiras através do registo em balanço de todos os ativos e passivos das locações, independentemente da forma de detenção dos ativos e do seu financiamento; e ii) dos indicadores de performance das empresas (KPI’s).

Da análise das contas do primeiro trimestre das principais operadoras de telecomunicações europeias, pode concluir-se que os maiores impactos da aplicação da referida norma, resultam do registo em balanço dos contratos de arrendamento de infraestruturas (sites) de rede móvel e rede fixa, lojas, edifícios, data centres e da apresentação em resultados da amortização do ROU e dos juros do passivo da locação. Simultaneamente, verifica-se que alguns KPI’s anteriormente usados para a avaliação da performance das empresas e acompanhados pelos stakeholders, foram agora significativamente alterados, dificultando a comparabilidade das empresas do setor, no que se refere à análise do grau de alavancagem e da avaliação das empresas. Como consequência e exemplo, algumas empresas passaram a apresentar o EBITDA AL (EBITDA After Leases), um novo KPI que difere significativamente do atual EBITDA, agora sem os gastos de arrendamentos e juros, ou seja, de montante significativamente superior ao EBITDA AL. Será o início do regresso ao passado e dar-se-á a substituição deste KPI pelo Cash Flow?

Apesar das Normas Internacionais de Contabilidade pretenderem a harmonização das informações financeiras apresentadas pelos emissores de valores mobiliários na União Europeia e garantir uma maior transparência e comparabilidade, é necessário a definição de um modelo “único” de divulgação das contas ao mercado e dos KPI’s apresentados, de modo a que uma nova norma, como a IFRS16, não prejudique a comparabilidade das empresas do setor.

Jornal Econômico (Portugal) - Jessica Pereira

11 julho 2019

Econometria é uma fraude

Grande boa parte dos modelos econométricos são inúteis. Vou elencar os motivos abaixo:

1) Em variáveis econômicas uma única observação em 10.000, ou seja, um único dia em 40 anos, pode explicar a maior parte da "curtose", a medida padrão de momento finito de caudas pesadas.

2) Para o mercado de ações dos EUA, um único dia, o crash de 1987, determinou 80% da curtose para o período entre 1952 e 2008. O mesmo problema ocorre com juros, taxa câmbio, commodities e outras variáveis econômicas e financeiras.

3) O problema não é apenas que os dados tenham caudas pesadas, algo que as pessoas sabem,

mas que não é possível determinar "caudas pesadas" usando métodos padrões. Isso implica que as ferramentas usadas pelos economistas baseadas na norma L2, ou seja variáveis elevadas ao quadrado, como desvio-padrão, variância, correlação, regressão não têm validade científica. A variância dos quadrados é análogo ao quarto momento. Além disso, p-valor não tem validade com variáveis econômicas e financeiras.

4) Os resultados da maioria dos trabalhos em economia são baseados nesses métodos estatísticos padrões .Portanto, não é esperado que esses estudos sejam replicados, e eles efetivamente não o fazem. Além disso, essas ferramentas incentivam a tomada de riscos não desejados.

5) Aí você pode se perguntar porque muita gente (acadêmicos e economistas) continua a usar métodos econométricos? Econometria captura coisas comuns e mascara efeitos de ordem superior, que são mais importantes. Como falências não são tão freqüentes, eventos extremos não aparecem em dados, então o pesquisador acadêmico parece inteligente na maioria das vezes, enquanto estão na verdade fundamentalmente errados.

6) A lei dos grandes números funciona bem devagar no mundo real, isso quando funciona.

7) A média da distribuição raramente corresponderá à média amostral, particularmente se

a distribuição tem assimetria;

8) Desvio-padrão e variância não podem ser usados em economia e finanças.

9) Beta, razão de Sharpe e outras métricas não são informativas.

10) Regressão Linear não funciona. O Teorema de Gauss-Markov falha, pois só é possível usá-lo quando a amostra é infinita. No mundo real, a amostra é finita. Ou seja, o mundo real é pré-assintótico.

Fonte: Nassim Nicholas Taleb. Errors, robustness, and the fourth quadrant. International

Journal of Forecasting, 25(4):744–759, 2009.

Data Science: a nova astrologia

I’ve spent most of the last six years playing around with data and drawing insights from it (a lot of those insights have been published in Mint). A lot of work that I’ve done can fall under the (rather large) umbrella of “data science", and some of it can be classified as “machine learning". Over the last couple of years, though, I’ve been rather disappointed by what goes on in the name of data science.

Stripped to its bare essentials, machine learning is an exercise in pattern recognition. Given a set of inputs and outputs, the system tunes a set of parameters in a mathematical formula such that the outputs can be predicted with as much accuracy as possible given the inputs (I’m massively oversimplifying here, but this captures sufficient essence for this discussion).

One big advantage with machine learning is that algorithms can sometimes recognize patterns that are not easily visible to the human eye. The most spectacular application of this has been in the field of medical imaging, where time and again algorithms have been shown to outperform human experts while analysing images.

In February last year, a team of researchers from Stanford University showed that a deep learning algorithm they had built performed on par against a team of expert doctors in detecting skin cancer. In July, another team from Stanford built an algorithm to detect heart arrhythmia by analysing electrocardiograms, and showed that it outperformed the average cardiologist. More recently, algorithms to detect pneumonia and breast cancer have been shown to perform better than expert doctors.

The way all these algorithms perform is similar—fed with large sets of images that contain both positive and negative cases of the condition to be detected, they calibrate parameters of a mathematical formula so that patterns that lead to positive and negative cases can be distinguished. Then, when fed with new images, they apply these formulae with the calibrated parameters in order to classify those images.

While applications such as medical imaging might make us believe that machine learning might take over the world, we should keep in mind that left to themselves, machines can go wrong spectacularly. In 2015, for example, Google got into trouble when it tagged photos containing a black woman as “gorillas".

Google admitted the mistake, and that the classification was “unacceptable" but it appears that its engineers couldn’t do much to prevent such classification. Last month, The Guardian reported that Google had gotten around this problem by removing tags such as “gorilla", “chimpanzee" and “monkey" from its database.

The advantage of machine learning—that it can pick up patterns that are not apparent to humans—can be its undoing as well. The gorilla problem aside, the problem with identifying patterns that are not apparent or intuitive to humans is that meaningless patterns can get picked up and amplified as well. In the statistics world, this is known as “spurious correlations".

And as we deal with larger and larger data sets, the possibility of such spurious correlations appearing out of sheer randomness increases. Nassim Nicholas Taleb, author of Fooled by Randomness and The Black Swan had written in 2013 about how “big data" would lead to “big errors".

We are seeing this with modern machine learning algorithms that rely on lots of data as well. For example, a team of researchers from New York University showed that algorithms detecting road signs can be fooled by simply inserting an additional set of training images with an obscure pattern in the corner. More importantly, they showed that a malicious adversary could choose these additional images carefully in a way that the misclassification wouldn’t be apparent when the model was being trained.

Traditionally, the most common method to get around spurious correlations has been for the statistician (or data scientist) to inspect their models and to make sure that they make “intuitive sense". In other words, the models are allowed to find patterns and then a domain expert validates those patterns. In case the patterns don’t make sense, data scientists have tweaked their models in a way that they give more meaningful results.

The other way statisticians have approached the problem is to pick models that are most appropriate for the data at hand. Different mathematical models are adept at detecting patterns in different kinds of data, and picking the right algorithm for the data ensures that spurious pattern detection is minimized.

The problem with modern machine learning algorithms, however, is that the models are hard to inspect and make sense of. It isn’t possible to look at the calibrated parameters of a deep learning system, for example, to see whether the patterns it detects make sense. In fact, “explainability" of artificial intelligence algorithms has become a major topic of interest among researchers.

Given the difficulty of explaining the models, the average data scientist proceeds to use the algorithms as black boxes. Moreover, determining the right model for a given data set is more of an art than science, and involves the process of visually inspecting the data and understanding the maths behind the models.

With standardized packages being available to do the maths, and in a “cheap" manner (a Python package called Scikit Learnallows data scientists to implement just about any machine learning model using three very similar looking lines of code), data scientists have gotten around this “problem".

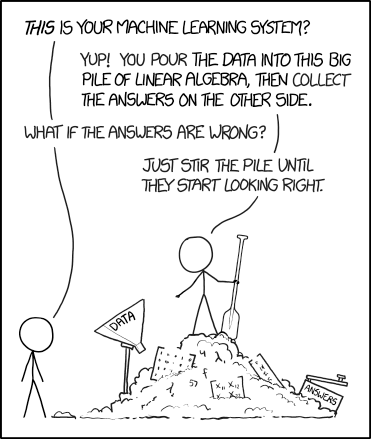

The way a large number of data scientists approach a problem is to take a data set and then apply all possible machine learning methods on it. They then accept the model that gives the best results on the data set at hand. No attempt is made to understand why the given inputs lead to the output, or if the patterns make “physical sense". As this XKCD strip puts it, this is akin to stirring a pile of answers till they start looking right.

And this is not very different from the way astrology works. There, we have a a bunch of predictor variables (position of different “planets" in various parts of the “sky") and observed variables (whether some disaster happened or not, in most cases). And then some of our ancients did some data analysis on this, trying to identify combinations of predictors that predicted the output (unfortunately, they didn’t have the power of statistics or computers, so in that sense the models were limited). And then they simply accepted the outputs, without challenging why it makes sense that the position of Jupiter at the time of wedding affects how someone’s marriage would go.

Armed with this analysis, I brought up the topic of astrology and data science again recently, telling my wife that “after careful analysis I admit that astrology is the oldest form of data science".

“That’s not what I said," Priyanka countered. “I said that data science is new-age astrology, and not the other way round."

Fonte: aqui

Fasb aprendendo a simplificar

O Fasb está convidando as pessoas a comentarem uma proposta de alteração na norma de goodwill. A norma atual seria altamente complexa, onde a relação custo-benefício da informação é desfavorável para a empresa.

Um aspecto interessante destacada por Jeff Drew em um texto para o Journal of Accountancy é papel do Private Company Council. Esta entidade foi criada para adaptar as normas do Fasb para as empresas de capital fechado dos Estados Unidos. Em muitos casos, o PCC indica quais normas devem ser seguidas, quais que não devem ser seguidas e, em certos casos, um tratamento alternativo e mais simplificado para a norma.

Parece que no caso do goodwill, o tratamento proposto pelo PCC reduziu custo e complexidade sem perda de qualidade da informação. Isto significa dizer que o PCC funcionou como um laboratório para melhorar a qualidade da norma e a relação custo-benefício da informação.

No Brasil não temos uma entidade similar. Em certos casos, o CFC faz um pouco este papel, ao propor uma norma para empresas de pequeno porte. Mesmo no Iasb isto termina por não acontecer.

Um aspecto interessante destacada por Jeff Drew em um texto para o Journal of Accountancy é papel do Private Company Council. Esta entidade foi criada para adaptar as normas do Fasb para as empresas de capital fechado dos Estados Unidos. Em muitos casos, o PCC indica quais normas devem ser seguidas, quais que não devem ser seguidas e, em certos casos, um tratamento alternativo e mais simplificado para a norma.

Parece que no caso do goodwill, o tratamento proposto pelo PCC reduziu custo e complexidade sem perda de qualidade da informação. Isto significa dizer que o PCC funcionou como um laboratório para melhorar a qualidade da norma e a relação custo-benefício da informação.

No Brasil não temos uma entidade similar. Em certos casos, o CFC faz um pouco este papel, ao propor uma norma para empresas de pequeno porte. Mesmo no Iasb isto termina por não acontecer.

Padrão na Contabilidade Forense

O AICPA divulgou um documento denominado Statement on Standards for Forensic Services No. 1, abrangendo litígio e investigação. Com quatro páginas e 11 itens, o documento traça aspectos gerais sobre a área. É válido para profissionais dos EUA que atuam na área.

10 julho 2019

Divergência na Remuneração

Um situação relacionada com o total de rendimento do executivo Elon Musk na Tesla expõe a dificuldade de mensuração na contabilidade. Tudo começou com uma reportagem do The New York Times que afirmou que o executivo Elon Musk recebeu no ano passado uma remuneração de 2,3 bilhões de dólares. Elon Musk é conhecido por ser um executivo inovador, mas polêmico. Em meados do ano passado esteve envolvido em uma divulgação de um Twitter sobre o fechamento do capital da Tesla.

Segundo o jornal, a remuneração de Musk estaria baseada em opções. Este valor é muito elevado. Para que o leitor tenha uma ideia, corresponde a 17 vezes a remuneração do que seria o segundo executivo mais bem remunerado dos Estados Unidos.

A Tesla contestou o texto do jornal. Segundo a empresa, o valor obtido por Musk foi de zero dólar em 2018. Há aqui um grande intervalo entre o valor informado pelo jornal, 2,3 bilhões, e o valor da empresa, de zero. Segundo a empresa, o plano de remuneração de Musk depende de uma série de metas de desempenho. E algumas destas metas seriam ambiciosas demais, o que faria com que a probabilidade de Musk receber a remuneração seja próxima de zero. Uma das metas seria que a empresa atingisse um valor de mercado de US$100 bilhões. Hoje este valor é de 41 bilhões. As metas também definem o valor da receita e de Ebitda, entre outros.