Nas pesquisas científicas quantitativas é comum usar como critério de decisão 0,05. Há controvérsias sobre quem foi o autor que endosso o uso de 0,05 como padrão para significância estatística (Aqui há uma boa discussão sobre isto). Nos últimos anos muitos cientistas são críticos com respeito a este padrão “sagrado”: “Certamente Deus ama 0,06 quase tanto quanto 0,05” (Rosenthal)

Nos tempos atuais, as pesquisas buscam de forma obsessiva o 0,05 e isto termina por conduzir a práticas como o p-hacking e a tortura dos dados. A defesa do abandono do uso do p-valor em pesquisa é uma consequência; alguns estatísticas (acho de Gelman é um deles) defendem que o pesquisa apresente os resultados e deixe a conclusão para o leitor. Os métodos bayesianos são citados como alternativas.

Uma ideia interessante é mudar o padrão: em lugar dos 0,05,que corresponde a uma estatística t de 1,96, utilizar um padrão que excede em muito este valor. Harvey, Liu e Zhu, em 2016, sugeriram uma estatística t igual a 3. Outros, a um p-valor de 0,005 ou uma estatística t de 2,81.

Qual seria a consequência disto? Muitas pesquisas empíricas publicadas nos últimos anos teriam seus resultados contestados, como mostra Baltussen, Swinkels e Vliet. Mais do que isto, muitos periódicos gostam de publicar pesquisas com resultados que sejam “interessantes” em termos estatísticos; o número destas pesquisas “publicáveis” reduziria substancialmente.

Harvey, Campbell; Liu, Yan; Zhu, Heqing. ... and the Cross-Section of Expected Returns. ssrn.com/abstract-2249314

Baltussen, Guido; Swinkels, Laurens; Van Vliet, Pim. Global Factor Premiums. ssrn.com/abstract=3325720

22 fevereiro 2019

21 fevereiro 2019

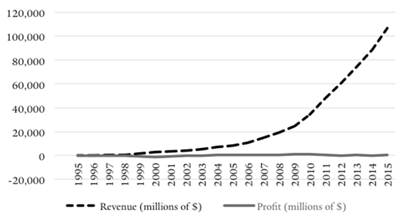

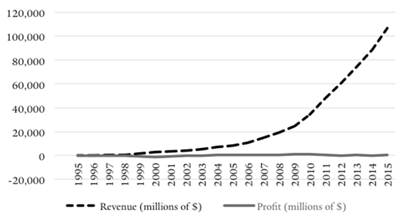

Fluxo de caixa negativo da Amazon e precificação predatória

A Amazon tornou-se uma das empresas mais valiosas do mundo operando com fluxo de caixa negativo e com lucro baixo ou inexistente por muitos anos. A estratégia de ter fluxo de caixa negativo talvez viole uma série de regras de antitruste, conforme discutido pela autora no artigo abaixo.

Resumo:

American jurisprudence considers price predation a largely irrational, and therefore self-limiting, business strategy which is unlikely to lead to monopolization of an industry. This paper argues that the recent rise of the negative cash flow firm upends traditional assumptions. These types of firms can achieve greater market share through predatory pricing strategies that involve long-term below average variable cost prices. It also maintains that recoupment, an essential element of any predatory pricing scheme, can be achieved without a raise of prices post predation. By charging prices in the present reflecting future lower costs based on prospective technological and scale efficiencies, these firms are able to rationalize their predatory pricing practices to investors and shareholders. These observations lead to the conclusion that price predation is a rational strategy which can foreseeably lead to monopolization. This paper then moves on to examine the conduct of Amazon, the biggest negative cash flow firm in the world. It suggests that not only is it entirely rational for Amazon to engage in price predation and a long-term strategy of monopolization but that under current corporate disclosure rules such conduct would be virtually undetectable. The negative impact of this behavior is the elimination present and future competition.

Shaoul Sussman; Prime Predator: Amazon and the Rational of Below Average Variable Cost Pricing Strategies Among Negative-Cash Flow Firms, Journal of Antitrust Enforcement, , jnz002, https://doi.org/10.1093/jaenfo/jnz002

Resumo:

American jurisprudence considers price predation a largely irrational, and therefore self-limiting, business strategy which is unlikely to lead to monopolization of an industry. This paper argues that the recent rise of the negative cash flow firm upends traditional assumptions. These types of firms can achieve greater market share through predatory pricing strategies that involve long-term below average variable cost prices. It also maintains that recoupment, an essential element of any predatory pricing scheme, can be achieved without a raise of prices post predation. By charging prices in the present reflecting future lower costs based on prospective technological and scale efficiencies, these firms are able to rationalize their predatory pricing practices to investors and shareholders. These observations lead to the conclusion that price predation is a rational strategy which can foreseeably lead to monopolization. This paper then moves on to examine the conduct of Amazon, the biggest negative cash flow firm in the world. It suggests that not only is it entirely rational for Amazon to engage in price predation and a long-term strategy of monopolization but that under current corporate disclosure rules such conduct would be virtually undetectable. The negative impact of this behavior is the elimination present and future competition.

Shaoul Sussman; Prime Predator: Amazon and the Rational of Below Average Variable Cost Pricing Strategies Among Negative-Cash Flow Firms, Journal of Antitrust Enforcement, , jnz002, https://doi.org/10.1093/jaenfo/jnz002

20 fevereiro 2019

Lei de Potência na Receita das Empresas Brasileiras

O artigo abaixo usa o ferramental da econofísica para modelar a granularidade das 1000 maiores empresas do brasil, de acordo com a receita líquida. Granuralidade siginifica que poucas grandes empresas convivem com muitas empresas pequenas.

Resumo:

“Granularity” refers to the fact that economies are populated by a few large companies (the big “grains”) that coexist with many smaller companies. Such a distribution of firm sizes is modeled by power laws. This study adds to the international evidence of the granularity hypothesis by considering data for the top 1,000 Brazilian companies. We sort the companies from top to bottom in terms of their net revenues. Then, we adjust power laws to the data and estimate Pareto and Gumbel exponents. We find we cannot dismiss the hypothesis of granularity for the Brazilian companies. We also find the Pareto exponent is approximately one (1.070 .015), roughly a Zipf’s law. Such a result is in line with the previous one found for American companies where the Pareto exponent = 1.059. We also find a power-law progress curve best fits the data.

Fonte: Da Silva, Sergio & Matsushita, Raul & Giglio, Ricardo & Massena, Gunther, 2018."Granularity of the top 1,000 Brazilian companies,"Physica A: Statistical Mechanics and its Applications,Elsevier, vol. 512(C), pages 68-73.

O gráfico de dispersão abaixo (log da receita x log do número de firmas) mostra que poucas empresas brasileiras concentram a maior parte das receitas. Assim, muitas empresas pequenas competem com poucas empresas grandes. Ou seja, a distribuição dos dados segue uma lei de potência.

Resumo:

“Granularity” refers to the fact that economies are populated by a few large companies (the big “grains”) that coexist with many smaller companies. Such a distribution of firm sizes is modeled by power laws. This study adds to the international evidence of the granularity hypothesis by considering data for the top 1,000 Brazilian companies. We sort the companies from top to bottom in terms of their net revenues. Then, we adjust power laws to the data and estimate Pareto and Gumbel exponents. We find we cannot dismiss the hypothesis of granularity for the Brazilian companies. We also find the Pareto exponent is approximately one (1.070 .015), roughly a Zipf’s law. Such a result is in line with the previous one found for American companies where the Pareto exponent = 1.059. We also find a power-law progress curve best fits the data.

Fonte: Da Silva, Sergio & Matsushita, Raul & Giglio, Ricardo & Massena, Gunther, 2018."Granularity of the top 1,000 Brazilian companies,"Physica A: Statistical Mechanics and its Applications,Elsevier, vol. 512(C), pages 68-73.

O gráfico de dispersão abaixo (log da receita x log do número de firmas) mostra que poucas empresas brasileiras concentram a maior parte das receitas. Assim, muitas empresas pequenas competem com poucas empresas grandes. Ou seja, a distribuição dos dados segue uma lei de potência.

19 fevereiro 2019

BT: Segue o jogo

Parece que algo está ocorrendo com os problemas contábeis que aconteceram com a BT na Itália. No início de 2017, noticiou-se que a filial italiana da empresa de telefonia britânica BT tinha receita superestimadas e outros problemas contábeis. O executivo da filial e outros gestores estão agora sendo responsabilizados por um caso que levou a uma amortização de 513 milhões de libras do balanço da BT. A investigação criminal deve resultar em acusações contra três executivos, que terão três semanas para apresentar sua defesa.

Quem era o auditor? A PwC, cujo sócio italiano está sendo também investigado. A acusação dos promotores é que Andrea Alessandri, líder da equipe da PwC, tenha falsificado a auditoria.

17 fevereiro 2019

Pemex

A Reuters lembra da difícil situação da empresa de petróleo estatal do México, a Pemex. A empresa passa por redução na produção do petróleo, corrupção e elevados custos trabalhistas. E roubo de combustível.

O retrato da contabilidade é realmente preocupante: dívida onerosa de 106 bilhões de dólares, sendo 27 bilhões a vencer nos próximos três anos. Parte disto deve ser renegociada.

A nota de crédito da empresa está perto do default. Com isto, o governo anunciou um plano de tentar recuperar a empresa. Isto inclui redução de impostos e mais capital (1,8 bilhão), para ajudar no refinanciamento da dívida.

O retrato da contabilidade é realmente preocupante: dívida onerosa de 106 bilhões de dólares, sendo 27 bilhões a vencer nos próximos três anos. Parte disto deve ser renegociada.

A nota de crédito da empresa está perto do default. Com isto, o governo anunciou um plano de tentar recuperar a empresa. Isto inclui redução de impostos e mais capital (1,8 bilhão), para ajudar no refinanciamento da dívida.

16 fevereiro 2019

Código de ética

Foi publicado (aqui e aqui) um novo código de ética da profissão contábil. Na divulgação da informação, o Conselho Federal de Contabilidade indica os motivos da nova atualização:

Segundo o presidente do CFC, Zulmir Breda, entre os principais objetivos, a atualização busca combater a mercantilização da profissão contábil. “Queremos combater a publicidade que deprecie e desmereça a atuação do profissional da contabilidade. Em qualquer modalidade ou veículo de comunicação, dos serviços contábeis, ela deve primar pela sua natureza técnica e científica, sendo vedada a prática da mercantilização”, disse.

No dia 7 de fevereiro, o texto foi aprovado pelo plenário do Conselho Federal de Contabilidade. As alterações foram realizadas por uma comissão, criada em 2017, que, em 2018, avaliou mais de 100 sugestões enviadas pela classe contábil, fruto de audiência pública promovida em fevereiro do ano passado.

Durante a Reunião Plenária, o vice-presidente Técnico do CFC, Idésio Coelho, apresentou as alterações e também explicou que as mudanças alinham o Código de Ética aos padrões internacionais de ética. O Código se aplica, também, às prerrogativas profissionais dos técnicos em contabilidade.

O texto entrará em vigor a partir de 1º de junho de 2019.

Não sou especialista em ética ou ética contábil. Mas alguns itens do novo Código me pareceram fora do escopo.

(o)cumprir os Programas de Educação Profissional Continuada de acordo com o estabelecido pelo Conselho Federal de Contabilidade (CFC);

(p)comunicar imediatamente ao CRC a mudança de seu domicílio ou endereço, inclusive eletrônico, e da organização contábil de sua responsabilidade, bem

como informar a ocorrência de outros fatos necessários ao controle e fiscalização profissional; (...)

Basicamente o código é composto por deveres (18), vedações (24) e quatro permissões.

Segundo o presidente do CFC, Zulmir Breda, entre os principais objetivos, a atualização busca combater a mercantilização da profissão contábil. “Queremos combater a publicidade que deprecie e desmereça a atuação do profissional da contabilidade. Em qualquer modalidade ou veículo de comunicação, dos serviços contábeis, ela deve primar pela sua natureza técnica e científica, sendo vedada a prática da mercantilização”, disse.

No dia 7 de fevereiro, o texto foi aprovado pelo plenário do Conselho Federal de Contabilidade. As alterações foram realizadas por uma comissão, criada em 2017, que, em 2018, avaliou mais de 100 sugestões enviadas pela classe contábil, fruto de audiência pública promovida em fevereiro do ano passado.

Durante a Reunião Plenária, o vice-presidente Técnico do CFC, Idésio Coelho, apresentou as alterações e também explicou que as mudanças alinham o Código de Ética aos padrões internacionais de ética. O Código se aplica, também, às prerrogativas profissionais dos técnicos em contabilidade.

O texto entrará em vigor a partir de 1º de junho de 2019.

Não sou especialista em ética ou ética contábil. Mas alguns itens do novo Código me pareceram fora do escopo.

(o)cumprir os Programas de Educação Profissional Continuada de acordo com o estabelecido pelo Conselho Federal de Contabilidade (CFC);

(p)comunicar imediatamente ao CRC a mudança de seu domicílio ou endereço, inclusive eletrônico, e da organização contábil de sua responsabilidade, bem

como informar a ocorrência de outros fatos necessários ao controle e fiscalização profissional; (...)

Basicamente o código é composto por deveres (18), vedações (24) e quatro permissões.

15 fevereiro 2019

A380 e Contabilidade de Custos

A empresa de fabricação de aviões Airbus anunciou que vai parar de produzir o A380. A principal razão é que seu principal cliente, a companhia de aviação Emirates, ter anunciado que não irá mais adquirir o jato.

O avião entrou em serviço em 2007. Enorme, o avião podia transportar até 850 passageiros. Com autonomia de 15.200 km e pesando 578 toneladas, o A380 produzia melhor custo por assento. Se estiver cheio. O pensamento da Airbus era que o crescimento do mercado de aviação demandaria aviões cada vez maiores. O desenvolvimento do avião custou 18 bilhões. Mas outras estimativas falam em 25 bilhões.

Fonte da Imagem

Mas a concepção do jato pode ter sido um erro:

Alguns analistas do setor, como Richard Aboulafia, analista do Teal Group, chegaram a dizer que foi o maior erro da história da Airbus. Segundo Aboulafia, o A380 é uma aeronave mal executada, projetada para um mercado que realmente não existe.

Em termos de estrutura de custos, um avião possui um elevado gasto de desenvolvimento. Isto precisa ser amortizado com as vendas. Além disto, geralmente os custos fixos são enormes, enquanto os custos variáveis são reduzidos. Assim, o ponto de equilíbrio de uma aeronave depende fortemente do número de encomendas e da quantidade de aviões produzidos por mês. O fato do A380 não ter uma encomenda forte para os próximos meses foi decisivo para a decisão da Airbus em cancelar sua produção. Mas o elevado custo antes da fase operacional também foi relevante.

Para quem se interessar, recomendo a seguinte leitura

Reinhardt, Uwe E. "BREAK‐EVEN ANALYSIS FOR LOCKHEED'S TRI STAR: AN APPLICATION OF FINANCIAL THEORY." The Journal of Finance 28.4 (1973): 821-838.

O avião entrou em serviço em 2007. Enorme, o avião podia transportar até 850 passageiros. Com autonomia de 15.200 km e pesando 578 toneladas, o A380 produzia melhor custo por assento. Se estiver cheio. O pensamento da Airbus era que o crescimento do mercado de aviação demandaria aviões cada vez maiores. O desenvolvimento do avião custou 18 bilhões. Mas outras estimativas falam em 25 bilhões.

Fonte da Imagem

Mas a concepção do jato pode ter sido um erro:

Alguns analistas do setor, como Richard Aboulafia, analista do Teal Group, chegaram a dizer que foi o maior erro da história da Airbus. Segundo Aboulafia, o A380 é uma aeronave mal executada, projetada para um mercado que realmente não existe.

Em termos de estrutura de custos, um avião possui um elevado gasto de desenvolvimento. Isto precisa ser amortizado com as vendas. Além disto, geralmente os custos fixos são enormes, enquanto os custos variáveis são reduzidos. Assim, o ponto de equilíbrio de uma aeronave depende fortemente do número de encomendas e da quantidade de aviões produzidos por mês. O fato do A380 não ter uma encomenda forte para os próximos meses foi decisivo para a decisão da Airbus em cancelar sua produção. Mas o elevado custo antes da fase operacional também foi relevante.

Para quem se interessar, recomendo a seguinte leitura

Reinhardt, Uwe E. "BREAK‐EVEN ANALYSIS FOR LOCKHEED'S TRI STAR: AN APPLICATION OF FINANCIAL THEORY." The Journal of Finance 28.4 (1973): 821-838.

Valor Justo no Super Mario Bros

Um cartucho do videogame clássico SuperMarioBros, lançado em 1985, foi vendido por US$100 mil dólares. O preço recorde decorre:

a) o fato do SuperMarioBros ser um jogo clássico

b) o cartucho vendido não ter tido sua embalagem violada

c) estar em excelente estado de preservação

d) existirem 11 variações da embalagem, mas as duas primeiras estavam disponíveis apenas no mercado de teste. A cópia vendida é uma destas embalagens

e) a embalagem tinha um adesivo da NES, o que é raro.

f) o tipo de embalagem geralmente se desgasta com o tempo, o que não ocorreu com esta cópia, mais de 30 anos depois

g) existe um grupo de colecionadores, muitos deles pessoas ricas, que são colecionadores de videogames.

h) o SuperMarioBros "salvou" a indústria de games

Eis um bom caso para discutir custo histórico e valor justo, não?

Fonte: Aqui

a) o fato do SuperMarioBros ser um jogo clássico

b) o cartucho vendido não ter tido sua embalagem violada

c) estar em excelente estado de preservação

d) existirem 11 variações da embalagem, mas as duas primeiras estavam disponíveis apenas no mercado de teste. A cópia vendida é uma destas embalagens

e) a embalagem tinha um adesivo da NES, o que é raro.

f) o tipo de embalagem geralmente se desgasta com o tempo, o que não ocorreu com esta cópia, mais de 30 anos depois

g) existe um grupo de colecionadores, muitos deles pessoas ricas, que são colecionadores de videogames.

h) o SuperMarioBros "salvou" a indústria de games

Eis um bom caso para discutir custo histórico e valor justo, não?

Fonte: Aqui

14 fevereiro 2019

Importantes limitações de Machine Learning

Estamos na era da abundância de informação e há todo momento vemos a imprensa falando de big data, machine learning e inteligência artificial. Há muita propaganda em torno do tema, pois os pesquisadores e entusiastas querem angariar dinheiro com o conhecimento que têm do tema, vendendo cursos, dando palestras etc. Ha aplicaçoes importantes de machine learning. Mas há um exagero em torno da aplicabilidade dessas ferramentas. Muitos deles acreditam que basta ter uma grande base de dados, um algoritmo computacional, que será possível resolver diversos problemas em várias áreas. No entanto, para isso acontecer é necessário o cumprimento de 2 hipóteses:

1) Dado amostra grande o suficiente de alguma distribuição, podemos aproximá-la eficientemente com um modelo estatístico, o que é conhecido como teorema da aproximação universal.

2) Uma amostra estatística de um fenômeno é suficiente para automatizar , raciocinar , prever o fenômeno;

No entanto, essas 2 hipóteses na maioria das vezes não ocorre na realidade:

1º Problema: Aproximação universal não é universal

There is a theoretical result known as the universal approximation theorem. In summary it states that any function can be approximated to an arbitrary precision by (at least) three level composition of real functions, such as e.g. a multilayer perceptron with sigmoidal activation. This is a mathematical statement, but a rather existential one. It does not say if such approximation would be practical or achievable with, say, gradient descent approach. It merely states that such approximation exists. As with many such existential arguments, their applicability to real world is limited. In the real world, we work with strictly finite (in fact even "small") systems that we simulate on the computer. Even though the models we exercise are "small", the parameter spaces are large enough, such that we cannot possibly search any significant portion of them. Instead we use gradient descent methods to actually find a solution, but by no means there are guarantees that we can find the best solution (or even good at all).[..]

2º Problema: O teorema do limite central tem limites

The second issue is that any time a dataset is created, it is assumed that the data contained in the set has a complete description of the phenomenon, and that there is a (high dimensional) distribution localised on some low dimensional manifold which captures the essence of the phenomenon. This strong belief is in part caused by the belief in the central limit theorem: a mathematical result that tells us something about averaging of random variables. [..]But there is a fine print: the theorem assumes that the original random variables had finite variance and expected values, were independent and identically distributed. Not all distributions have those properties! In particular critical phenomena exhibit fat tail distributions which often have unbounded variance and undefined expected values (not to mention many real world samples are actually not independent or identically distributed).

3º Problema: O mundo está sempre mudando ( em termos técnicos: o mundo é não estacionário)

Aside from the fact that many real world phenomena may exhibit rather hairy fat tail distributions, there is another quirk which is often not captured in datasets: that phenomena are not always stationary. In other words, the world keeps evolving, changing the context and consequently altering fundamental statistical properties of many real world phenomena. Therefore a stationary distribution (a snapshot) at a given time may not work indefinitely[...]

These things happen all the time, potentially changing the daily/weekly/monthly patterns of behaviours. The pace at which things are changing may be to quick for statistical models to follow, even if they retrain online. Granted there are certainly aspects of behaviour and some humans which are very stable: some people work in the same place for many years and have very stable patterns of behaviours. But this cannot be assumed in general.

Fonte: aqui

1) Dado amostra grande o suficiente de alguma distribuição, podemos aproximá-la eficientemente com um modelo estatístico, o que é conhecido como teorema da aproximação universal.

2) Uma amostra estatística de um fenômeno é suficiente para automatizar , raciocinar , prever o fenômeno;

No entanto, essas 2 hipóteses na maioria das vezes não ocorre na realidade:

1º Problema: Aproximação universal não é universal

There is a theoretical result known as the universal approximation theorem. In summary it states that any function can be approximated to an arbitrary precision by (at least) three level composition of real functions, such as e.g. a multilayer perceptron with sigmoidal activation. This is a mathematical statement, but a rather existential one. It does not say if such approximation would be practical or achievable with, say, gradient descent approach. It merely states that such approximation exists. As with many such existential arguments, their applicability to real world is limited. In the real world, we work with strictly finite (in fact even "small") systems that we simulate on the computer. Even though the models we exercise are "small", the parameter spaces are large enough, such that we cannot possibly search any significant portion of them. Instead we use gradient descent methods to actually find a solution, but by no means there are guarantees that we can find the best solution (or even good at all).[..]

2º Problema: O teorema do limite central tem limites

The second issue is that any time a dataset is created, it is assumed that the data contained in the set has a complete description of the phenomenon, and that there is a (high dimensional) distribution localised on some low dimensional manifold which captures the essence of the phenomenon. This strong belief is in part caused by the belief in the central limit theorem: a mathematical result that tells us something about averaging of random variables. [..]But there is a fine print: the theorem assumes that the original random variables had finite variance and expected values, were independent and identically distributed. Not all distributions have those properties! In particular critical phenomena exhibit fat tail distributions which often have unbounded variance and undefined expected values (not to mention many real world samples are actually not independent or identically distributed).

3º Problema: O mundo está sempre mudando ( em termos técnicos: o mundo é não estacionário)

Aside from the fact that many real world phenomena may exhibit rather hairy fat tail distributions, there is another quirk which is often not captured in datasets: that phenomena are not always stationary. In other words, the world keeps evolving, changing the context and consequently altering fundamental statistical properties of many real world phenomena. Therefore a stationary distribution (a snapshot) at a given time may not work indefinitely[...]

These things happen all the time, potentially changing the daily/weekly/monthly patterns of behaviours. The pace at which things are changing may be to quick for statistical models to follow, even if they retrain online. Granted there are certainly aspects of behaviour and some humans which are very stable: some people work in the same place for many years and have very stable patterns of behaviours. But this cannot be assumed in general.

Fonte: aqui

Assinar:

Postagens (Atom)