Um artigo de um jornal português sobre a norma de Leasing.

A IFRS 16 – Locações entrou em vigor a 1 de janeiro de 2019 e teve os seus reflexos na publicação das contas das empresas no primeiro trimestre do ano. Segundo alguns analistas o objetivo da norma não foi totalmente atingido. Qual a razão para que tal tenha acontecido?

A IFRS 16 requere que os locatários contabilizem todas as locações (“operacionais” e “financeiras) com base num modelo único de reconhecimento no balanço. Assim, na data de início da locação, o locatário reconhece a responsabilidade relacionada com os pagamentos da locação e o ativo que representa o direito a usar o bem subjacente (ROU), durante o período da locação.

Simultaneamente, é reconhecido o custo do juro sobre o passivo da locação e a respetiva amortização do ROU. O objetivo pretendido com a norma seria permitir a comparabilidade: i) das demonstrações financeiras através do registo em balanço de todos os ativos e passivos das locações, independentemente da forma de detenção dos ativos e do seu financiamento; e ii) dos indicadores de performance das empresas (KPI’s).

Da análise das contas do primeiro trimestre das principais operadoras de telecomunicações europeias, pode concluir-se que os maiores impactos da aplicação da referida norma, resultam do registo em balanço dos contratos de arrendamento de infraestruturas (sites) de rede móvel e rede fixa, lojas, edifícios, data centres e da apresentação em resultados da amortização do ROU e dos juros do passivo da locação. Simultaneamente, verifica-se que alguns KPI’s anteriormente usados para a avaliação da performance das empresas e acompanhados pelos stakeholders, foram agora significativamente alterados, dificultando a comparabilidade das empresas do setor, no que se refere à análise do grau de alavancagem e da avaliação das empresas. Como consequência e exemplo, algumas empresas passaram a apresentar o EBITDA AL (EBITDA After Leases), um novo KPI que difere significativamente do atual EBITDA, agora sem os gastos de arrendamentos e juros, ou seja, de montante significativamente superior ao EBITDA AL. Será o início do regresso ao passado e dar-se-á a substituição deste KPI pelo Cash Flow?

Apesar das Normas Internacionais de Contabilidade pretenderem a harmonização das informações financeiras apresentadas pelos emissores de valores mobiliários na União Europeia e garantir uma maior transparência e comparabilidade, é necessário a definição de um modelo “único” de divulgação das contas ao mercado e dos KPI’s apresentados, de modo a que uma nova norma, como a IFRS16, não prejudique a comparabilidade das empresas do setor.

Jornal Econômico (Portugal) - Jessica Pereira

12 julho 2019

11 julho 2019

Econometria é uma fraude

Grande boa parte dos modelos econométricos são inúteis. Vou elencar os motivos abaixo:

1) Em variáveis econômicas uma única observação em 10.000, ou seja, um único dia em 40 anos, pode explicar a maior parte da "curtose", a medida padrão de momento finito de caudas pesadas.

2) Para o mercado de ações dos EUA, um único dia, o crash de 1987, determinou 80% da curtose para o período entre 1952 e 2008. O mesmo problema ocorre com juros, taxa câmbio, commodities e outras variáveis econômicas e financeiras.

3) O problema não é apenas que os dados tenham caudas pesadas, algo que as pessoas sabem,

mas que não é possível determinar "caudas pesadas" usando métodos padrões. Isso implica que as ferramentas usadas pelos economistas baseadas na norma L2, ou seja variáveis elevadas ao quadrado, como desvio-padrão, variância, correlação, regressão não têm validade científica. A variância dos quadrados é análogo ao quarto momento. Além disso, p-valor não tem validade com variáveis econômicas e financeiras.

4) Os resultados da maioria dos trabalhos em economia são baseados nesses métodos estatísticos padrões .Portanto, não é esperado que esses estudos sejam replicados, e eles efetivamente não o fazem. Além disso, essas ferramentas incentivam a tomada de riscos não desejados.

5) Aí você pode se perguntar porque muita gente (acadêmicos e economistas) continua a usar métodos econométricos? Econometria captura coisas comuns e mascara efeitos de ordem superior, que são mais importantes. Como falências não são tão freqüentes, eventos extremos não aparecem em dados, então o pesquisador acadêmico parece inteligente na maioria das vezes, enquanto estão na verdade fundamentalmente errados.

6) A lei dos grandes números funciona bem devagar no mundo real, isso quando funciona.

7) A média da distribuição raramente corresponderá à média amostral, particularmente se

a distribuição tem assimetria;

8) Desvio-padrão e variância não podem ser usados em economia e finanças.

9) Beta, razão de Sharpe e outras métricas não são informativas.

10) Regressão Linear não funciona. O Teorema de Gauss-Markov falha, pois só é possível usá-lo quando a amostra é infinita. No mundo real, a amostra é finita. Ou seja, o mundo real é pré-assintótico.

Fonte: Nassim Nicholas Taleb. Errors, robustness, and the fourth quadrant. International

Journal of Forecasting, 25(4):744–759, 2009.

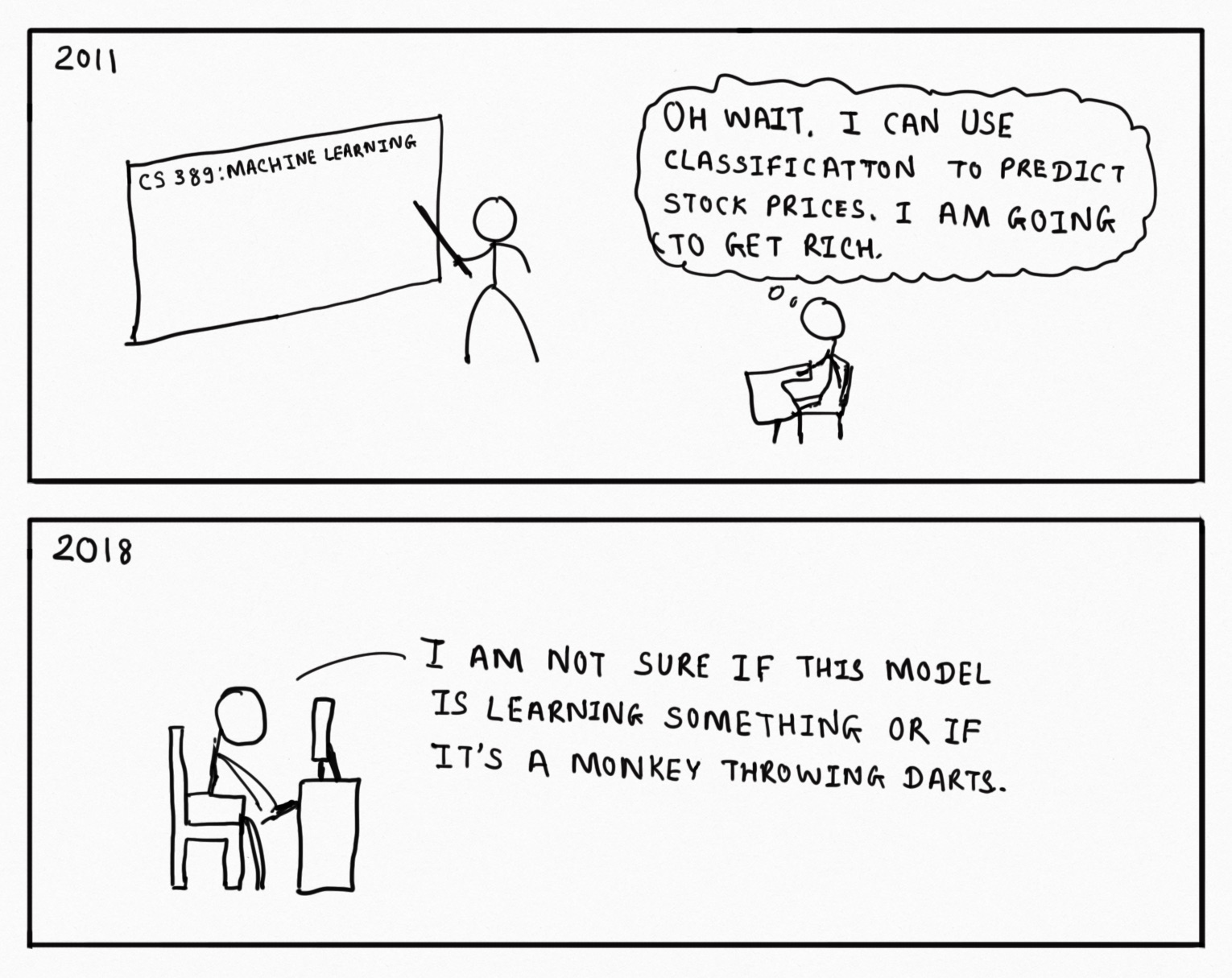

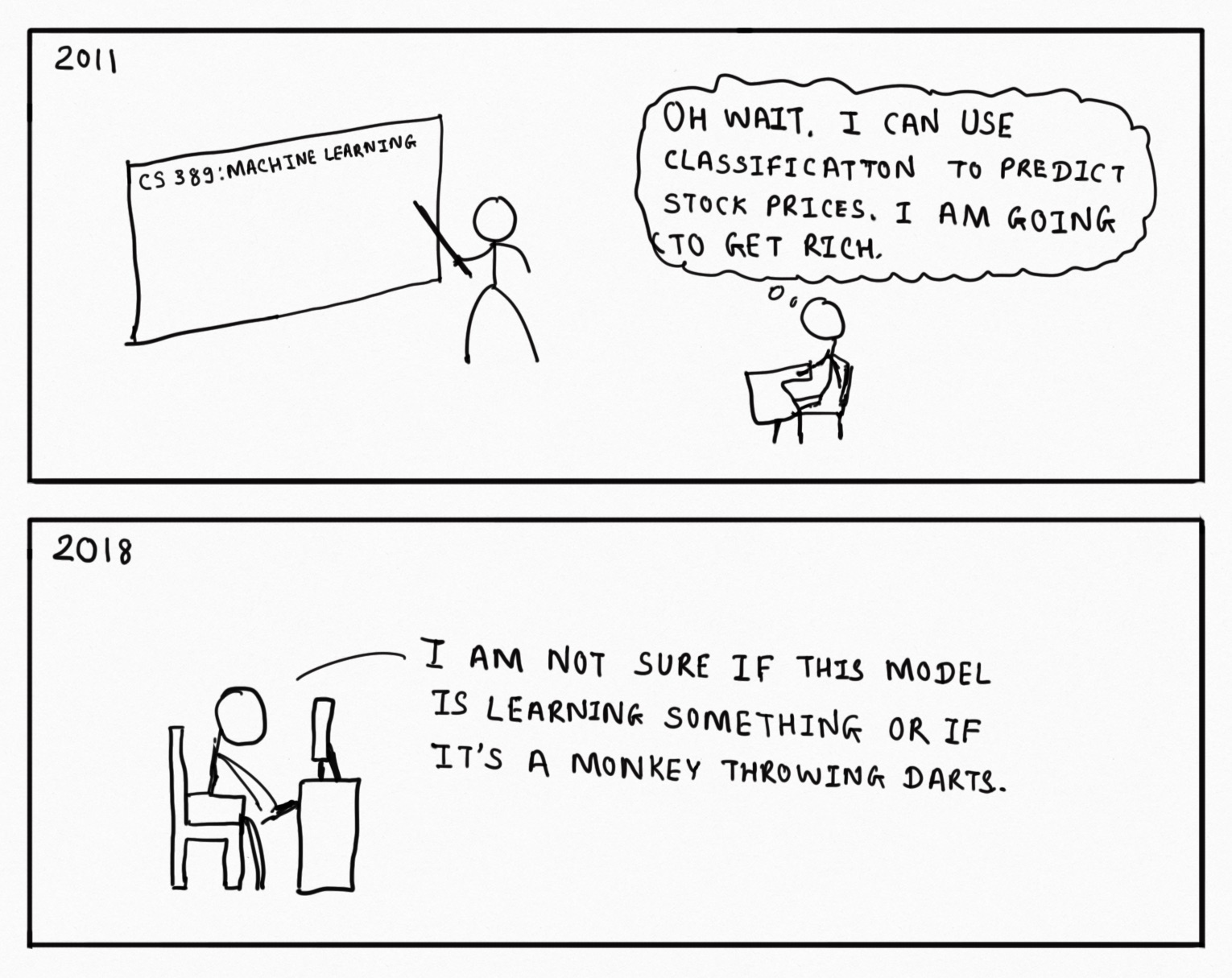

Data Science: a nova astrologia

I’ve spent most of the last six years playing around with data and drawing insights from it (a lot of those insights have been published in Mint). A lot of work that I’ve done can fall under the (rather large) umbrella of “data science", and some of it can be classified as “machine learning". Over the last couple of years, though, I’ve been rather disappointed by what goes on in the name of data science.

Stripped to its bare essentials, machine learning is an exercise in pattern recognition. Given a set of inputs and outputs, the system tunes a set of parameters in a mathematical formula such that the outputs can be predicted with as much accuracy as possible given the inputs (I’m massively oversimplifying here, but this captures sufficient essence for this discussion).

One big advantage with machine learning is that algorithms can sometimes recognize patterns that are not easily visible to the human eye. The most spectacular application of this has been in the field of medical imaging, where time and again algorithms have been shown to outperform human experts while analysing images.

In February last year, a team of researchers from Stanford University showed that a deep learning algorithm they had built performed on par against a team of expert doctors in detecting skin cancer. In July, another team from Stanford built an algorithm to detect heart arrhythmia by analysing electrocardiograms, and showed that it outperformed the average cardiologist. More recently, algorithms to detect pneumonia and breast cancer have been shown to perform better than expert doctors.

The way all these algorithms perform is similar—fed with large sets of images that contain both positive and negative cases of the condition to be detected, they calibrate parameters of a mathematical formula so that patterns that lead to positive and negative cases can be distinguished. Then, when fed with new images, they apply these formulae with the calibrated parameters in order to classify those images.

While applications such as medical imaging might make us believe that machine learning might take over the world, we should keep in mind that left to themselves, machines can go wrong spectacularly. In 2015, for example, Google got into trouble when it tagged photos containing a black woman as “gorillas".

Google admitted the mistake, and that the classification was “unacceptable" but it appears that its engineers couldn’t do much to prevent such classification. Last month, The Guardian reported that Google had gotten around this problem by removing tags such as “gorilla", “chimpanzee" and “monkey" from its database.

The advantage of machine learning—that it can pick up patterns that are not apparent to humans—can be its undoing as well. The gorilla problem aside, the problem with identifying patterns that are not apparent or intuitive to humans is that meaningless patterns can get picked up and amplified as well. In the statistics world, this is known as “spurious correlations".

And as we deal with larger and larger data sets, the possibility of such spurious correlations appearing out of sheer randomness increases. Nassim Nicholas Taleb, author of Fooled by Randomness and The Black Swan had written in 2013 about how “big data" would lead to “big errors".

We are seeing this with modern machine learning algorithms that rely on lots of data as well. For example, a team of researchers from New York University showed that algorithms detecting road signs can be fooled by simply inserting an additional set of training images with an obscure pattern in the corner. More importantly, they showed that a malicious adversary could choose these additional images carefully in a way that the misclassification wouldn’t be apparent when the model was being trained.

Traditionally, the most common method to get around spurious correlations has been for the statistician (or data scientist) to inspect their models and to make sure that they make “intuitive sense". In other words, the models are allowed to find patterns and then a domain expert validates those patterns. In case the patterns don’t make sense, data scientists have tweaked their models in a way that they give more meaningful results.

The other way statisticians have approached the problem is to pick models that are most appropriate for the data at hand. Different mathematical models are adept at detecting patterns in different kinds of data, and picking the right algorithm for the data ensures that spurious pattern detection is minimized.

The problem with modern machine learning algorithms, however, is that the models are hard to inspect and make sense of. It isn’t possible to look at the calibrated parameters of a deep learning system, for example, to see whether the patterns it detects make sense. In fact, “explainability" of artificial intelligence algorithms has become a major topic of interest among researchers.

Given the difficulty of explaining the models, the average data scientist proceeds to use the algorithms as black boxes. Moreover, determining the right model for a given data set is more of an art than science, and involves the process of visually inspecting the data and understanding the maths behind the models.

With standardized packages being available to do the maths, and in a “cheap" manner (a Python package called Scikit Learnallows data scientists to implement just about any machine learning model using three very similar looking lines of code), data scientists have gotten around this “problem".

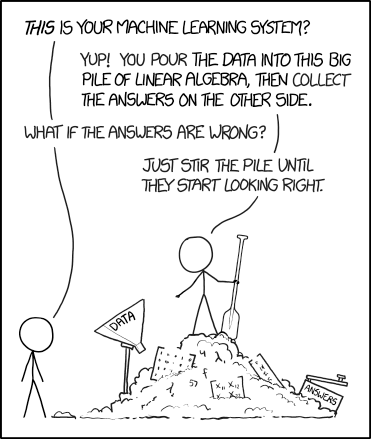

The way a large number of data scientists approach a problem is to take a data set and then apply all possible machine learning methods on it. They then accept the model that gives the best results on the data set at hand. No attempt is made to understand why the given inputs lead to the output, or if the patterns make “physical sense". As this XKCD strip puts it, this is akin to stirring a pile of answers till they start looking right.

And this is not very different from the way astrology works. There, we have a a bunch of predictor variables (position of different “planets" in various parts of the “sky") and observed variables (whether some disaster happened or not, in most cases). And then some of our ancients did some data analysis on this, trying to identify combinations of predictors that predicted the output (unfortunately, they didn’t have the power of statistics or computers, so in that sense the models were limited). And then they simply accepted the outputs, without challenging why it makes sense that the position of Jupiter at the time of wedding affects how someone’s marriage would go.

Armed with this analysis, I brought up the topic of astrology and data science again recently, telling my wife that “after careful analysis I admit that astrology is the oldest form of data science".

“That’s not what I said," Priyanka countered. “I said that data science is new-age astrology, and not the other way round."

Fonte: aqui

Fasb aprendendo a simplificar

O Fasb está convidando as pessoas a comentarem uma proposta de alteração na norma de goodwill. A norma atual seria altamente complexa, onde a relação custo-benefício da informação é desfavorável para a empresa.

Um aspecto interessante destacada por Jeff Drew em um texto para o Journal of Accountancy é papel do Private Company Council. Esta entidade foi criada para adaptar as normas do Fasb para as empresas de capital fechado dos Estados Unidos. Em muitos casos, o PCC indica quais normas devem ser seguidas, quais que não devem ser seguidas e, em certos casos, um tratamento alternativo e mais simplificado para a norma.

Parece que no caso do goodwill, o tratamento proposto pelo PCC reduziu custo e complexidade sem perda de qualidade da informação. Isto significa dizer que o PCC funcionou como um laboratório para melhorar a qualidade da norma e a relação custo-benefício da informação.

No Brasil não temos uma entidade similar. Em certos casos, o CFC faz um pouco este papel, ao propor uma norma para empresas de pequeno porte. Mesmo no Iasb isto termina por não acontecer.

Um aspecto interessante destacada por Jeff Drew em um texto para o Journal of Accountancy é papel do Private Company Council. Esta entidade foi criada para adaptar as normas do Fasb para as empresas de capital fechado dos Estados Unidos. Em muitos casos, o PCC indica quais normas devem ser seguidas, quais que não devem ser seguidas e, em certos casos, um tratamento alternativo e mais simplificado para a norma.

Parece que no caso do goodwill, o tratamento proposto pelo PCC reduziu custo e complexidade sem perda de qualidade da informação. Isto significa dizer que o PCC funcionou como um laboratório para melhorar a qualidade da norma e a relação custo-benefício da informação.

No Brasil não temos uma entidade similar. Em certos casos, o CFC faz um pouco este papel, ao propor uma norma para empresas de pequeno porte. Mesmo no Iasb isto termina por não acontecer.

Padrão na Contabilidade Forense

O AICPA divulgou um documento denominado Statement on Standards for Forensic Services No. 1, abrangendo litígio e investigação. Com quatro páginas e 11 itens, o documento traça aspectos gerais sobre a área. É válido para profissionais dos EUA que atuam na área.

10 julho 2019

Divergência na Remuneração

Um situação relacionada com o total de rendimento do executivo Elon Musk na Tesla expõe a dificuldade de mensuração na contabilidade. Tudo começou com uma reportagem do The New York Times que afirmou que o executivo Elon Musk recebeu no ano passado uma remuneração de 2,3 bilhões de dólares. Elon Musk é conhecido por ser um executivo inovador, mas polêmico. Em meados do ano passado esteve envolvido em uma divulgação de um Twitter sobre o fechamento do capital da Tesla.

Segundo o jornal, a remuneração de Musk estaria baseada em opções. Este valor é muito elevado. Para que o leitor tenha uma ideia, corresponde a 17 vezes a remuneração do que seria o segundo executivo mais bem remunerado dos Estados Unidos.

A Tesla contestou o texto do jornal. Segundo a empresa, o valor obtido por Musk foi de zero dólar em 2018. Há aqui um grande intervalo entre o valor informado pelo jornal, 2,3 bilhões, e o valor da empresa, de zero. Segundo a empresa, o plano de remuneração de Musk depende de uma série de metas de desempenho. E algumas destas metas seriam ambiciosas demais, o que faria com que a probabilidade de Musk receber a remuneração seja próxima de zero. Uma das metas seria que a empresa atingisse um valor de mercado de US$100 bilhões. Hoje este valor é de 41 bilhões. As metas também definem o valor da receita e de Ebitda, entre outros.

Um aspecto interessante é que a remuneração de Musk não promove um efetivo incentivo para o executivo. Atualmente, Musk é proprietário de um grande número de ações da Tesla. Assim, receber opções de ações não corresponde a um incentivo para o executivo. O valor divulgado no jornal corresponde ao potencial de preço da ação no futuro e das outras metas definidas no contrato.

Texto baseado em Business Insider, Elon Musk got 'paid' $2.3 billion last year but actually earned $0, and this shows how complicated CEO compensation has become

Segundo o jornal, a remuneração de Musk estaria baseada em opções. Este valor é muito elevado. Para que o leitor tenha uma ideia, corresponde a 17 vezes a remuneração do que seria o segundo executivo mais bem remunerado dos Estados Unidos.

A Tesla contestou o texto do jornal. Segundo a empresa, o valor obtido por Musk foi de zero dólar em 2018. Há aqui um grande intervalo entre o valor informado pelo jornal, 2,3 bilhões, e o valor da empresa, de zero. Segundo a empresa, o plano de remuneração de Musk depende de uma série de metas de desempenho. E algumas destas metas seriam ambiciosas demais, o que faria com que a probabilidade de Musk receber a remuneração seja próxima de zero. Uma das metas seria que a empresa atingisse um valor de mercado de US$100 bilhões. Hoje este valor é de 41 bilhões. As metas também definem o valor da receita e de Ebitda, entre outros.

Um aspecto interessante é que a remuneração de Musk não promove um efetivo incentivo para o executivo. Atualmente, Musk é proprietário de um grande número de ações da Tesla. Assim, receber opções de ações não corresponde a um incentivo para o executivo. O valor divulgado no jornal corresponde ao potencial de preço da ação no futuro e das outras metas definidas no contrato.

Texto baseado em Business Insider, Elon Musk got 'paid' $2.3 billion last year but actually earned $0, and this shows how complicated CEO compensation has become

Tesouro Nacional e Turma da Mônica

O Tesouro Nacional está realizando um projeto com a Turma da Mônica visando apresentar temas como equilíbrio fiscal, transparência e qualidade do gasto na gestão pública e controle social a crianças de 8 a 11 anos. Seguem as duas primeiras edições:

Em Busca do Tesouro - Onde Está o Tesouro

Em Busca do Tesouro - O Tesouro é Nosso

Enviado por Glauber Barbosa, a quem agradecemos.

Em Busca do Tesouro - Onde Está o Tesouro

Em Busca do Tesouro - O Tesouro é Nosso

Enviado por Glauber Barbosa, a quem agradecemos.

Qualidade da auditoria no Reino Unido

Segundo a Reuters, as principais empresas de auditoria do Reino Unido não fizeram um trabalho de qualidade pelo segundo ano consecutivo. Isto ocorreu depois de falhas com a construtora Carillion, o varejista BHS e a doceria Patisserie Valerie. Além da Big Four, a BDO, Grant Thornton e Mazars não conseguiram que 90% dos trabalhos realizados e revisados pelo Financial Reporting Council (FRC) fossem considerados de qualidade adequada.

Em relação ao ano passado, não ocorreu melhoria. Isto não seria um problema, se as empresas de auditoria não estivessem sob críticas depois dos problemas com as empresas listadas acima. E em dezembro de 2018 começou a discutir uma proposta de mudança nos reguladores, o que inclui a proposta de extinção do FRC, por uma organização mais forte. Já comentamos isto anteriormente no blog.

Entre as propostas, as grandes empresas teriam dois auditores. O grande problema é que a atenção do Reino Unido está voltada para a saída da União Europeia. Uma entidade profissional, o ICAEW, reconheceu os problemas do setor de auditoria no Reino Unido e que a reforma deveria ser implantada imediatamente.

Entre as propostas, as grandes empresas teriam dois auditores. O grande problema é que a atenção do Reino Unido está voltada para a saída da União Europeia. Uma entidade profissional, o ICAEW, reconheceu os problemas do setor de auditoria no Reino Unido e que a reforma deveria ser implantada imediatamente.

As mudanças passam por uma consulta pública. O ministro Greg Clark quer melhorar a qualidade da auditoria. É bom lembrar que o Reino Unido sempre foi um local onde a boa contabilidade foi praticada. Além disto, é sede administrativa da Fundação IFRS.

Em relação ao ano passado, não ocorreu melhoria. Isto não seria um problema, se as empresas de auditoria não estivessem sob críticas depois dos problemas com as empresas listadas acima. E em dezembro de 2018 começou a discutir uma proposta de mudança nos reguladores, o que inclui a proposta de extinção do FRC, por uma organização mais forte. Já comentamos isto anteriormente no blog.

Entre as propostas, as grandes empresas teriam dois auditores. O grande problema é que a atenção do Reino Unido está voltada para a saída da União Europeia. Uma entidade profissional, o ICAEW, reconheceu os problemas do setor de auditoria no Reino Unido e que a reforma deveria ser implantada imediatamente.

Entre as propostas, as grandes empresas teriam dois auditores. O grande problema é que a atenção do Reino Unido está voltada para a saída da União Europeia. Uma entidade profissional, o ICAEW, reconheceu os problemas do setor de auditoria no Reino Unido e que a reforma deveria ser implantada imediatamente. As mudanças passam por uma consulta pública. O ministro Greg Clark quer melhorar a qualidade da auditoria. É bom lembrar que o Reino Unido sempre foi um local onde a boa contabilidade foi praticada. Além disto, é sede administrativa da Fundação IFRS.

09 julho 2019

Teste de QI é uma fraude

Taleb argumenta que o teste QI é uma fraude pseudocientífica. Vou tentar resumir os argumentos dele:

1) Teste de QI é uma medida útil para pessoas acostumadas a fazer testes e que vivem em ambientes controlados que não tem conexão com o mundo real: burocratas, acadêmicos, pessoas que vivem de salário etc. Não há relação estatística significante entre teste de QI e riqueza, por exemplo.

2) Teste de QI não mede capacidade intelectual. Se você quiser detectar como alguém se sai numa tarefa específica, faça com que ele execute a tarefa. Não é necessário exame teórico para examinar esse tipo de competência;

3) Caudas pesadas. O teste de QI é construído com base na distribuição normal. No entanto, o desempenho no mundo real tem cauda pesada. Assim, a covariância entre QI e o desempenho em determinada tarefa não existe ou não é informativa;

4) A inteligência nos testes de QI é determinada por psicólogos acadêmicos;

5) No mundo acadêmico não há diferença entre a academia e o mundo real. Mas no mundo real há diferença.

6) A vida real nunca oferece perguntas nítidas com respostas nítidas;

7) Quando alguém lhe faz uma pergunta no mundo real, você se concentra primeiro em “por que ele está me perguntando isso?”, o que te leva ao meio ambiente e reduz o problema em questão.

8) O pior problema com o QI é que parece escolher pessoas que não gostam de dizer "não há resposta, não perca tempo, encontre outra coisa".

9) Para ser bem sucedido na na vida você precisa de profundidade e habilidade para selecionar seus próprios problemas e pensar independentemente.

10) Ao contrário das medidas de altura ou riqueza, que carregam um pequeno erro relativo, muitas pessoas obtêm resultados bastante diferentes para o mesmo teste de QI.

11) Acadêmicos e médicos têm QI mais alto, pois para exercer essas carreiras é preciso passar em testes semelhantes aos testes de QI.

12) Teste de QI também poderia ser renomeado para teste para pessoas assalariadas, pois mede a capacidade de ser um bom escravo confinado a tarefas lineares.

13) O argumento dos psicólogos para justificar o teste de QI é algo do tipo: quem você gostaria que quisesse uma cirurgia cerebral em você , alguém com um QI de 90 ou um com 130 ?Bem, você escolhe pessoas com base no desempenho específico da tarefa, o que deve incluir alguma filtragem. No mundo real, você entrevista pessoas e olha currículo (ninguém olha o QI) e, depois de ter seu currículo examinado, o colega de QI baixo é naturalmente eliminado. Assim, a única coisa que o teste de QI pode selecionar, o deficiente mental, já é eliminado na vida real: ele não pode ter um diploma em engenharia ou medicina. O que explica a razão do teste de QI ser desnecessário. Além disso, usá-lo é arriscado porque você perde os Einsteins e os Feynmans.

14) “QI” tem capacidade de prever de desempenho em treinamento militar, com correlação ~ .5;

15) O efeito Flynn deveria nos alertar não apenas que o QI é um tanto dependente do ambiente, mas que é pelo menos parcialmente circular.

1) Teste de QI é uma medida útil para pessoas acostumadas a fazer testes e que vivem em ambientes controlados que não tem conexão com o mundo real: burocratas, acadêmicos, pessoas que vivem de salário etc. Não há relação estatística significante entre teste de QI e riqueza, por exemplo.

2) Teste de QI não mede capacidade intelectual. Se você quiser detectar como alguém se sai numa tarefa específica, faça com que ele execute a tarefa. Não é necessário exame teórico para examinar esse tipo de competência;

3) Caudas pesadas. O teste de QI é construído com base na distribuição normal. No entanto, o desempenho no mundo real tem cauda pesada. Assim, a covariância entre QI e o desempenho em determinada tarefa não existe ou não é informativa;

4) A inteligência nos testes de QI é determinada por psicólogos acadêmicos;

5) No mundo acadêmico não há diferença entre a academia e o mundo real. Mas no mundo real há diferença.

6) A vida real nunca oferece perguntas nítidas com respostas nítidas;

7) Quando alguém lhe faz uma pergunta no mundo real, você se concentra primeiro em “por que ele está me perguntando isso?”, o que te leva ao meio ambiente e reduz o problema em questão.

8) O pior problema com o QI é que parece escolher pessoas que não gostam de dizer "não há resposta, não perca tempo, encontre outra coisa".

9) Para ser bem sucedido na na vida você precisa de profundidade e habilidade para selecionar seus próprios problemas e pensar independentemente.

10) Ao contrário das medidas de altura ou riqueza, que carregam um pequeno erro relativo, muitas pessoas obtêm resultados bastante diferentes para o mesmo teste de QI.

11) Acadêmicos e médicos têm QI mais alto, pois para exercer essas carreiras é preciso passar em testes semelhantes aos testes de QI.

12) Teste de QI também poderia ser renomeado para teste para pessoas assalariadas, pois mede a capacidade de ser um bom escravo confinado a tarefas lineares.

13) O argumento dos psicólogos para justificar o teste de QI é algo do tipo: quem você gostaria que quisesse uma cirurgia cerebral em você , alguém com um QI de 90 ou um com 130 ?Bem, você escolhe pessoas com base no desempenho específico da tarefa, o que deve incluir alguma filtragem. No mundo real, você entrevista pessoas e olha currículo (ninguém olha o QI) e, depois de ter seu currículo examinado, o colega de QI baixo é naturalmente eliminado. Assim, a única coisa que o teste de QI pode selecionar, o deficiente mental, já é eliminado na vida real: ele não pode ter um diploma em engenharia ou medicina. O que explica a razão do teste de QI ser desnecessário. Além disso, usá-lo é arriscado porque você perde os Einsteins e os Feynmans.

14) “QI” tem capacidade de prever de desempenho em treinamento militar, com correlação ~ .5;

15) O efeito Flynn deveria nos alertar não apenas que o QI é um tanto dependente do ambiente, mas que é pelo menos parcialmente circular.

Tem um livro que trata do assunto:

QI, Expectativa e Escolha

A busca pelos atributos que fazem uma pessoa tomar boas decisões traz uma pesquisa interessante realizada na Finlândia. Quatro pesquisadores, Francesco D'Acunto, Daniel Hoang, Maritta Paloviita e Michael Weber, aproveitaram os dados disponíveis do país escandinavo para verificar se o quociente de inteligência, o QI, de alguma maneira afeta as decisões realizadas pelas pessoas.

Na Finlândia, os homens que são incorporados às forças armadas são obrigados a fazer o teste de QI. Usando estes resultados, com testes realizados entre 2001 a 2015, os pesquisadores conseguiram obter algumas conclusões importantes. Neste caso, a Finlândia, sendo uma sociedade homogênea, com bom acesso à escola para todas as pessoas e baixa desigualdade social, é um local adequado para este tipo de pesquisa. Em razão destas três características, além do fato da amostra ser composta por homens, o resultado não foi influenciado por classes sociais, formação escolar ou gênero do pesquisado. O foco dos pesquisadores era tentar entender como as pessoas formam suas expectativas e como isto pode ser influenciado por uma habilidade, medida aqui pelo QI.

Uma crítica que se faz ao teste do QI é o Flynn Effect. Em termos mais simples, as pesquisas observaram que com o passar do tempo, a nota do teste tem aumentado de maneira constante. É como se a população estivesse aprendendo a fazer o teste a cada ano transcorrido. A pesquisa fez um tratamento para este problema, para evitar este efeito.

Com o resultado do teste de muitos homens que serviram nas forças armadas da Finlândia, os pesquisadores perguntaram qual a expectativa de comportamento da inflação nos próximos 12 meses, em uma escala que variava de -100 a 100 por cento. Também perguntaram se a situação econômica era favorável para compra de bens de consumo duráveis. Em um país como a Finlândia, a previsão da inflação futura deve estar próxima de zero. Entretanto, muitos responderam com valores fora de um padrão “esperado”.

O interessante é que o erro na previsão estava relacionado com o QI da pessoa. Eis um gráfico que mostra os homens com maiores quociente de inteligência erraram menos a projeção da inflação. Além disto, os pesquisadores perceberam que algumas pessoas fizeram previsões muito acima do padrão usual. Há um viés já comprovado nas pesquisas que as pessoas tendem a “chutar” em torno de múltiplos de 5. Assim, é bastante comum arriscar, na projeção de inflação, valores como 5%, 10%, 15% e assim por diante. Ao relacionarem este viés com o quociente de inteligência, os pesquisadores também encontraram que pessoas com menores QIs cometem este erro.

A pesquisa também olhou se edução e renda tinham efeito no resultado. Mesmo sendo uma sociedade igualitária, ainda assim existem pessoas com melhores rendimentos ou melhor educação que outras. Nenhuma das duas variáveis apresentou um resultado que poderia ajudar a explicar o erro de previsão.

Uma vertente da pesquisa foi verificar o comportamento das pessoas em termos de economia e empréstimo. Novamente, o QI parece indicar que as pessoas mais inteligentes são aquelas que economizam para a aposentadoria e tomam emprestado para financiar sua educação, mas não o seu consumo. Isto corresponderia a um comportamento mais saudável por parte das pessoas.

A pesquisa pode ser lida no site do Bank of Finland, Discussion Paper 2/2019

Na Finlândia, os homens que são incorporados às forças armadas são obrigados a fazer o teste de QI. Usando estes resultados, com testes realizados entre 2001 a 2015, os pesquisadores conseguiram obter algumas conclusões importantes. Neste caso, a Finlândia, sendo uma sociedade homogênea, com bom acesso à escola para todas as pessoas e baixa desigualdade social, é um local adequado para este tipo de pesquisa. Em razão destas três características, além do fato da amostra ser composta por homens, o resultado não foi influenciado por classes sociais, formação escolar ou gênero do pesquisado. O foco dos pesquisadores era tentar entender como as pessoas formam suas expectativas e como isto pode ser influenciado por uma habilidade, medida aqui pelo QI.

Uma crítica que se faz ao teste do QI é o Flynn Effect. Em termos mais simples, as pesquisas observaram que com o passar do tempo, a nota do teste tem aumentado de maneira constante. É como se a população estivesse aprendendo a fazer o teste a cada ano transcorrido. A pesquisa fez um tratamento para este problema, para evitar este efeito.

Com o resultado do teste de muitos homens que serviram nas forças armadas da Finlândia, os pesquisadores perguntaram qual a expectativa de comportamento da inflação nos próximos 12 meses, em uma escala que variava de -100 a 100 por cento. Também perguntaram se a situação econômica era favorável para compra de bens de consumo duráveis. Em um país como a Finlândia, a previsão da inflação futura deve estar próxima de zero. Entretanto, muitos responderam com valores fora de um padrão “esperado”.

O interessante é que o erro na previsão estava relacionado com o QI da pessoa. Eis um gráfico que mostra os homens com maiores quociente de inteligência erraram menos a projeção da inflação. Além disto, os pesquisadores perceberam que algumas pessoas fizeram previsões muito acima do padrão usual. Há um viés já comprovado nas pesquisas que as pessoas tendem a “chutar” em torno de múltiplos de 5. Assim, é bastante comum arriscar, na projeção de inflação, valores como 5%, 10%, 15% e assim por diante. Ao relacionarem este viés com o quociente de inteligência, os pesquisadores também encontraram que pessoas com menores QIs cometem este erro.

A pesquisa também olhou se edução e renda tinham efeito no resultado. Mesmo sendo uma sociedade igualitária, ainda assim existem pessoas com melhores rendimentos ou melhor educação que outras. Nenhuma das duas variáveis apresentou um resultado que poderia ajudar a explicar o erro de previsão.

Uma vertente da pesquisa foi verificar o comportamento das pessoas em termos de economia e empréstimo. Novamente, o QI parece indicar que as pessoas mais inteligentes são aquelas que economizam para a aposentadoria e tomam emprestado para financiar sua educação, mas não o seu consumo. Isto corresponderia a um comportamento mais saudável por parte das pessoas.

A pesquisa pode ser lida no site do Bank of Finland, Discussion Paper 2/2019

Blog novo: Conta Mais Contabilidade

Olha que ótima notícia: há um blog novo na área. O responsável pelo Conta Mais Contabilidade é o Rodolfo Rodrigues, do Rio Grande do Norte. O nordeste marcando presença no nosso mundo virtual!

https://contamaiscontabilidade.wordpress.com/

Se você conhece algum blog que não está no nosso blogroll, por favor nos avise aqui nos comentários ou nos mande um e-mail em blogcontabilidadefinanceira@gmail.com.

Também temos um blog só para listar os blogs! ;) Basta clicar: aqui.

08 julho 2019

Previsão em Finanças via Machine Learning é muito difícil

[...]

It’s not for lack of interest on Wall Street’s part. The effort to scientifically model markets, which began in the mid-1980s, has absorbed the talents of some of the brightest graduates of math and computer science programs. A handful of secretive hedge fund managers—including Renaissance Technologies, PDT Partners, and D.E. Shaw—have carved out extraordinary returns. But tellingly, many of the leading operations today are the same ones that dominated scientific modeling decades ago. And you probably aren’t rich enough or connected enough to invest with them.

One reason machine investing remains an elite domain is obvious. By definition, most investors can’t beat the average, and every computer that momentarily finds a winning formula will soon face others trying to outwit it. But it turns out that investing is also simply harder than, say, predicting your next Amazon purchase. “It’s one of the most difficult problems in applied machine learning,” says Ciamac Moallemi, a professor at Columbia Business School and a principal at Bourbaki LLC. Here are just some of the devilish problems financial engineers are trying to crack:

The Data Keeps Changing

Or, in quantspeak, it’s nonstationary. An example of stationary data might be the distance between your left eye and your nose. Unless you have plastic surgery, it’s a constant. If a machine is fed hundreds of pictures of you, it will be able to identify you with high probability.

In financial markets, data can change dramatically and in unprecedented ways—for example, when interest rates turned negative across much of Europe and Japan in 2013. Other shifts can be more mundane. In 1998 pricing of U.S. stocks went to decimals from fractions. That wasn’t hard for computers to adjust to, but it might have flustered some of the human traders. “It changed some structure in the market and probably some behavior, too,” says Glen Whitney, a former researcher at Renaissance.

There’s More Noise Than Signal

Stocks move all the time, and not always for any discernible reason. Most market moves are what economists call noise trading. To go back to the image-recognition analogy, imagine a computer trying to identify people in photos that were taken in the dark. Most of the data in those pictures is noise—useless black pixels.

What’s more, as data sets go, the history of stock prices is relatively thin. Say you’re trying to predict how stocks will perform over a one-year horizon. Because we only have decent records back to 1900, there are only 118 nonoverlapping one-year periods to look at in the U.S. Compare this with Facebook Inc., which has an endless trove of stuff to comb through—it processes 350 million pictures a day. And in image recognition, simple tricks such as rotating the photo or altering colors can increase the amount of data; it’s difficult to artificially increase the size of a financial data set.

The Edge You’re Looking for Is Really Small

An obvious signal—for example, to buy stocks on the first day of every month—is not of much use. If that worked in the past, it was probably just a fluke, and even if it isn’t, it’s going to be quickly discovered and traded away by others. So researchers have focused on very faint signals, ones that might predict the future price with only 51% certainty. “We were looking for patterns that are just on the edge of detection,” Whitney says. Most investors can’t take advantage of such patterns. To make them work, money managers have to combine thousands of bets and magnify them with leverage—investing with borrowed money.

Prediction can be improved only so much, forcing elite quantitative managers to look for other advantages. In investing, one profitable problem to solve is transaction costs.

The obvious transaction cost is the fee the broker charges. But there’s also something called slippage, which accounts for the quoted price—$135 for a share of IBM Corp., for example—being relative to the number of shares you want to buy. You might be able to buy only 100 shares at $135; to buy 1,000 shares would require bidding a higher price to attract new sellers. The average cost might then be $136. The only way to know the true price, with slippage, is to transact in the market.

Teaching a machine to anticipate transaction costs helps in two ways. First, the edge required for a trading signal to be profitable might go from 51% to 50.5%. The second advantage is that more can be squeezed from an opportunity. Imagine a widely known model identifies IBM as 1% undervalued. Without understanding transaction costs, a typical company might trade only 1,000 shares, lest it risk too much slippage and push prices above the 1% spread it’s seeking to capture. A company that knows, with perhaps 80% probability, that in fact 5,000 shares can be safely bought without moving the market to higher prices can make a bigger bet. Many in the industry say Renaissance has the most advanced understanding of transaction costs, and that’s one secret to its unequaled track record.

To squeeze transaction costs further, some quant managers build their own high-frequency trading operations, in which they can act as market makers, earning money by matching buyers and sellers. But just as important, running these platforms helps them gain deeper insights into the behavior of the market. It’s akin to Warren Buffett having his own traders on the floor of the New York Stock Exchange rather than using a Wall Street brokerage. Buffett’s own people might tell him things about the mood on the floor that the brokers’ wouldn’t.

Another workaround for quant managers struggling with market data is to find other kinds of information to mine. They’re feeding into their computers everything from satellite photos of parking lots to social media feeds. “Alternative data might be more helpful to firms that are less skilled at wringing signal out of classic data sets,” says Jon McAuliffe, a professor at the University of California at Berkeley and the chief investment officer at Voleon Capital Management LP. Trouble is, such data gets easier and easier to find, so it may not provide an edge for long. (Bloomberg LP, which owns Bloomberg Businessweek, provides clients with access to alternative data.)

Given the complexity of noisy data, most companies try to keep the models as simple as possible. Nick Patterson, who spent a decade as a researcher at Renaissance, says, “One tool that Renaissance uses is linear regression, which a high school student could understand” (OK, a particularly smart high school student; it’s about finding the relationship between two variables). He adds: “It’s simple, but effective if you know how to avoid mistakes just waiting to be made.” Legend holds that at one time the crown jewels of the firm could be written down on a single 8.5-by-11-inch sheet of paper.

As much as hedge funds are using computers for data crunching and pattern recognition, finding new market signals is still a human endeavor. Elite quantitative managers employ huge staffs—sometimes in the hundreds—and show up at machine learning conferences to recruit fresh Ph.D.s.

To build a truly autonomous investing system—one in which the computer itself is thinking about signals and strategies to try—researchers will likely need to crack the problem of causality. That means not only noticing that, for instance, a rise in a particular stock is often accompanied by a bump in interest rates, but also being able to come up with a reason for it. Humans are good at this kind of thinking, but AI has only started to make progress.

Another method, known as deep learning, has driven recent advances in AI, such as image recognition and speech translation. Researchers are tying to bring it to finance, though its use is still limited. Zack Lipton, a professor at Carnegie Mellon, has co-authored a paper showing one possible approach. It addresses the noise problem by predicting not stock prices, but the changes in company fundamentals—such as revenue or profit margins—that ultimately drive returns.

The adversarial nature of trading means that most developments remain shrouded in secrecy. That makes high-quality AI scientists hard to recruit. Scientists like to publish and collaborate. “We love discovering new things about markets and have a great community of people within the firm that we’re able to share results with, but unfortunately we can’t communicate them to a wider audience,” says Pete Muller, the founder of PDT Partners LLC and a pioneer in the field.

The prospect of searching for ghostly signals that eventually disappear can also dissuade some people from working in finance. “In my mind, a top researcher would need a two- to five-times salary multiple to completely forgo the ability to publish and make the lifestyle trade-offs necessary to work in finance,” Lipton says. Still, there’s the lure of a tough problem, combined with the chance to make serious money. “Using machines to beat the markets is a really difficult challenge,” says McAuliffe, whose résumé includes biological research and a stint at Amazon.com Inc. “But I don’t think it’s impossible.”

Fonte: aqui

It’s not for lack of interest on Wall Street’s part. The effort to scientifically model markets, which began in the mid-1980s, has absorbed the talents of some of the brightest graduates of math and computer science programs. A handful of secretive hedge fund managers—including Renaissance Technologies, PDT Partners, and D.E. Shaw—have carved out extraordinary returns. But tellingly, many of the leading operations today are the same ones that dominated scientific modeling decades ago. And you probably aren’t rich enough or connected enough to invest with them.

One reason machine investing remains an elite domain is obvious. By definition, most investors can’t beat the average, and every computer that momentarily finds a winning formula will soon face others trying to outwit it. But it turns out that investing is also simply harder than, say, predicting your next Amazon purchase. “It’s one of the most difficult problems in applied machine learning,” says Ciamac Moallemi, a professor at Columbia Business School and a principal at Bourbaki LLC. Here are just some of the devilish problems financial engineers are trying to crack:

The Data Keeps Changing

Or, in quantspeak, it’s nonstationary. An example of stationary data might be the distance between your left eye and your nose. Unless you have plastic surgery, it’s a constant. If a machine is fed hundreds of pictures of you, it will be able to identify you with high probability.

In financial markets, data can change dramatically and in unprecedented ways—for example, when interest rates turned negative across much of Europe and Japan in 2013. Other shifts can be more mundane. In 1998 pricing of U.S. stocks went to decimals from fractions. That wasn’t hard for computers to adjust to, but it might have flustered some of the human traders. “It changed some structure in the market and probably some behavior, too,” says Glen Whitney, a former researcher at Renaissance.

There’s More Noise Than Signal

Stocks move all the time, and not always for any discernible reason. Most market moves are what economists call noise trading. To go back to the image-recognition analogy, imagine a computer trying to identify people in photos that were taken in the dark. Most of the data in those pictures is noise—useless black pixels.

What’s more, as data sets go, the history of stock prices is relatively thin. Say you’re trying to predict how stocks will perform over a one-year horizon. Because we only have decent records back to 1900, there are only 118 nonoverlapping one-year periods to look at in the U.S. Compare this with Facebook Inc., which has an endless trove of stuff to comb through—it processes 350 million pictures a day. And in image recognition, simple tricks such as rotating the photo or altering colors can increase the amount of data; it’s difficult to artificially increase the size of a financial data set.

The Edge You’re Looking for Is Really Small

An obvious signal—for example, to buy stocks on the first day of every month—is not of much use. If that worked in the past, it was probably just a fluke, and even if it isn’t, it’s going to be quickly discovered and traded away by others. So researchers have focused on very faint signals, ones that might predict the future price with only 51% certainty. “We were looking for patterns that are just on the edge of detection,” Whitney says. Most investors can’t take advantage of such patterns. To make them work, money managers have to combine thousands of bets and magnify them with leverage—investing with borrowed money.

Prediction can be improved only so much, forcing elite quantitative managers to look for other advantages. In investing, one profitable problem to solve is transaction costs.

The obvious transaction cost is the fee the broker charges. But there’s also something called slippage, which accounts for the quoted price—$135 for a share of IBM Corp., for example—being relative to the number of shares you want to buy. You might be able to buy only 100 shares at $135; to buy 1,000 shares would require bidding a higher price to attract new sellers. The average cost might then be $136. The only way to know the true price, with slippage, is to transact in the market.

Teaching a machine to anticipate transaction costs helps in two ways. First, the edge required for a trading signal to be profitable might go from 51% to 50.5%. The second advantage is that more can be squeezed from an opportunity. Imagine a widely known model identifies IBM as 1% undervalued. Without understanding transaction costs, a typical company might trade only 1,000 shares, lest it risk too much slippage and push prices above the 1% spread it’s seeking to capture. A company that knows, with perhaps 80% probability, that in fact 5,000 shares can be safely bought without moving the market to higher prices can make a bigger bet. Many in the industry say Renaissance has the most advanced understanding of transaction costs, and that’s one secret to its unequaled track record.

To squeeze transaction costs further, some quant managers build their own high-frequency trading operations, in which they can act as market makers, earning money by matching buyers and sellers. But just as important, running these platforms helps them gain deeper insights into the behavior of the market. It’s akin to Warren Buffett having his own traders on the floor of the New York Stock Exchange rather than using a Wall Street brokerage. Buffett’s own people might tell him things about the mood on the floor that the brokers’ wouldn’t.

Another workaround for quant managers struggling with market data is to find other kinds of information to mine. They’re feeding into their computers everything from satellite photos of parking lots to social media feeds. “Alternative data might be more helpful to firms that are less skilled at wringing signal out of classic data sets,” says Jon McAuliffe, a professor at the University of California at Berkeley and the chief investment officer at Voleon Capital Management LP. Trouble is, such data gets easier and easier to find, so it may not provide an edge for long. (Bloomberg LP, which owns Bloomberg Businessweek, provides clients with access to alternative data.)

Given the complexity of noisy data, most companies try to keep the models as simple as possible. Nick Patterson, who spent a decade as a researcher at Renaissance, says, “One tool that Renaissance uses is linear regression, which a high school student could understand” (OK, a particularly smart high school student; it’s about finding the relationship between two variables). He adds: “It’s simple, but effective if you know how to avoid mistakes just waiting to be made.” Legend holds that at one time the crown jewels of the firm could be written down on a single 8.5-by-11-inch sheet of paper.

As much as hedge funds are using computers for data crunching and pattern recognition, finding new market signals is still a human endeavor. Elite quantitative managers employ huge staffs—sometimes in the hundreds—and show up at machine learning conferences to recruit fresh Ph.D.s.

To build a truly autonomous investing system—one in which the computer itself is thinking about signals and strategies to try—researchers will likely need to crack the problem of causality. That means not only noticing that, for instance, a rise in a particular stock is often accompanied by a bump in interest rates, but also being able to come up with a reason for it. Humans are good at this kind of thinking, but AI has only started to make progress.

Another method, known as deep learning, has driven recent advances in AI, such as image recognition and speech translation. Researchers are tying to bring it to finance, though its use is still limited. Zack Lipton, a professor at Carnegie Mellon, has co-authored a paper showing one possible approach. It addresses the noise problem by predicting not stock prices, but the changes in company fundamentals—such as revenue or profit margins—that ultimately drive returns.

The adversarial nature of trading means that most developments remain shrouded in secrecy. That makes high-quality AI scientists hard to recruit. Scientists like to publish and collaborate. “We love discovering new things about markets and have a great community of people within the firm that we’re able to share results with, but unfortunately we can’t communicate them to a wider audience,” says Pete Muller, the founder of PDT Partners LLC and a pioneer in the field.

The prospect of searching for ghostly signals that eventually disappear can also dissuade some people from working in finance. “In my mind, a top researcher would need a two- to five-times salary multiple to completely forgo the ability to publish and make the lifestyle trade-offs necessary to work in finance,” Lipton says. Still, there’s the lure of a tough problem, combined with the chance to make serious money. “Using machines to beat the markets is a really difficult challenge,” says McAuliffe, whose résumé includes biological research and a stint at Amazon.com Inc. “But I don’t think it’s impossible.”

Fonte: aqui

Quais são as economias hiperinflacionárias?

Com o retorno do tratamento à inflação na contabilidade brasileira (vide aqui), resta saber em que situações o IAS 29 deve ser aplicado. O International Practices Task Force (IPTF) of the Centre for Audit Quality (CAQ) (via aqui) considerando os dados de diversos países, considera como status de economias "altamente inflacionárias", baseado nos critérios do IAS 29, a seguinte listagem:

Economias com inflação de três anos acima de 100%:

Angola

Argentina

República Democrática do Congo

Sudão do Sul

Sudão

Venezuela

Economias com inflação projetada de três anos maior que 100%:

República Islâmica do Irã

Iémen

Zimbábue

Economias com inflação de três anos superiores a 100% após um pico de inflação:

Suriname

Economias com inflação em três anos entre 70% e 100% ou com um aumento significativo (25% ou mais) da inflação durante o período atual

Libéria

Líbia

Economias com inflação de três anos acima de 100%:

Angola

Argentina

República Democrática do Congo

Sudão do Sul

Sudão

Venezuela

Economias com inflação projetada de três anos maior que 100%:

República Islâmica do Irã

Iémen

Zimbábue

Economias com inflação de três anos superiores a 100% após um pico de inflação:

Suriname

Economias com inflação em três anos entre 70% e 100% ou com um aumento significativo (25% ou mais) da inflação durante o período atual

Libéria

Líbia

Letras mais usadas na língua portuguesa

Eis uma listagem interessante e útil: as letras que mais aparecem na língua portuguesa. Usando um dicionário de português, a partir de 32 mil lemas (ou raiz de uma palavra). Eis a ordem, as

Interesse, sim. Mas útil? Quem nunca jogou "forca"?

07 julho 2019

Machine Learning em Finanças: prever é muito difícil

Machine Learning é algo antigo que é usado desde os anos 1980 no mercado financeiro. Apesar de toda evolução dos algoritmos nos últimos anos, a capacidade de previsão dessas ferramanentas é muita pequena.

Em suma: os mercados financeiros são inerentemente imprevisíveis. Existem vários motivos pelos quais é tão difícil prever. O engenheiro indiano Hardik Patel , que trabalha no Google e foi chefe num fundo quantitativo em nova york, destaca os principais motivos que dificultam isso.

1 º Distribuição dos dados: O futuro é distinto do passado. Esse é um problema comum quando se trata de aplicar o aprendizado de máquina a problemas do mundo real. Além de garantir que os conjuntos de teste e treino tenham distribuições semelhantes, também é preciso garantir que o modelo treinado seja usado apenas quando os dados futuros estiverem em conformidade com a distribuição do treinamento / validação.

2 º Amostra dos dados pequena: quando o conjunto de dados é bem pequeno, como no caso de estatísticas de desemprego fica bem difícil fazer previsões.

3 º Previsão em finanças é algo bem complexo: muitas coisas afetam os preços em diferentes escalas:

a) Em intervalos de alta frequência, o preço dos ativos é afetado pelos algoritmos de negociação;

b) Os preços de abertura e fechamento têm seus próprios padrões - tanto em ações quanto em futuros

c) Notícias e rumores são as forças motrizes quando se trata de horizontes de vários dias. Notícias específicas da empresa podem acontecer a qualquer momento sem aviso prévio. No entanto, a linha do tempo para alguns eventos é conhecida de antemão. O cronograma de resultados da empresa, bem como o calendário de dados econômicos, são conhecidos de antemão.

d) Valuation e os ciclos econômicos são importantes quando se trata de mudanças de preços em faixas de vários anos.

4º Outros problemas:

a) Previsões financeiras têm baixa acurácia;

b) Há muito ruído nos dados;

c)Dados financeiros têm sazonalidade;

d) Há eventos que nunca foram vistos pela máquina; os dados financeiros podem conter eventos totalmente diferentes do que estava disponível durante o treinamento do modelo.

e) um conjunto de dados financeiros pode consistir em preços de frequência mais altos, bem como dados econômicos de menor frequência.

Em suma: os mercados financeiros são inerentemente imprevisíveis. Existem vários motivos pelos quais é tão difícil prever. O engenheiro indiano Hardik Patel , que trabalha no Google e foi chefe num fundo quantitativo em nova york, destaca os principais motivos que dificultam isso.

1 º Distribuição dos dados: O futuro é distinto do passado. Esse é um problema comum quando se trata de aplicar o aprendizado de máquina a problemas do mundo real. Além de garantir que os conjuntos de teste e treino tenham distribuições semelhantes, também é preciso garantir que o modelo treinado seja usado apenas quando os dados futuros estiverem em conformidade com a distribuição do treinamento / validação.

2 º Amostra dos dados pequena: quando o conjunto de dados é bem pequeno, como no caso de estatísticas de desemprego fica bem difícil fazer previsões.

3 º Previsão em finanças é algo bem complexo: muitas coisas afetam os preços em diferentes escalas:

a) Em intervalos de alta frequência, o preço dos ativos é afetado pelos algoritmos de negociação;

b) Os preços de abertura e fechamento têm seus próprios padrões - tanto em ações quanto em futuros

c) Notícias e rumores são as forças motrizes quando se trata de horizontes de vários dias. Notícias específicas da empresa podem acontecer a qualquer momento sem aviso prévio. No entanto, a linha do tempo para alguns eventos é conhecida de antemão. O cronograma de resultados da empresa, bem como o calendário de dados econômicos, são conhecidos de antemão.

d) Valuation e os ciclos econômicos são importantes quando se trata de mudanças de preços em faixas de vários anos.

4º Outros problemas:

a) Previsões financeiras têm baixa acurácia;

b) Há muito ruído nos dados;

c)Dados financeiros têm sazonalidade;

d) Há eventos que nunca foram vistos pela máquina; os dados financeiros podem conter eventos totalmente diferentes do que estava disponível durante o treinamento do modelo.

e) um conjunto de dados financeiros pode consistir em preços de frequência mais altos, bem como dados econômicos de menor frequência.

Domínio CPA

Os domínios da internet são regulados por uma entidade chamada ICANN. Esta é uma entidade sem fins lucrativos, vinculada ao governo dos Estados Unidos.

Agora, o AICPA, o Instituto de Contadores Públicos Certificados, com 330 mil membros, anunciou que o domínio CPA estará sob sua responsabilidade. Desde 2015 o presidente da entidade AICPA pressionava para obter esta responsabilidade. O presidente do AICPA estava preocupado com a possibilidade de alguém, que não fosse um contador público certificado, usasse e abusasse do domínio.

Isto pode ser um sinal de que o domínio ser usado especialmente por contadores públicos ou por pessoas que estariam dentro dos padrões e critérios definidos pelo AICPA. Entretanto, o Going Concern lembra que uma investigação em 68 mil domínios com "cpa" não achou evidências de problemas. O site, ironicamente, afirma:

Meaning there aren’t wild bands of rogue Internet trolls camping CPA domains for the purpose of diluting public trust or worse, offering professional services without a license. Go figure, Internet criminals have better things to do it seems.

Agora, o AICPA, o Instituto de Contadores Públicos Certificados, com 330 mil membros, anunciou que o domínio CPA estará sob sua responsabilidade. Desde 2015 o presidente da entidade AICPA pressionava para obter esta responsabilidade. O presidente do AICPA estava preocupado com a possibilidade de alguém, que não fosse um contador público certificado, usasse e abusasse do domínio.

Isto pode ser um sinal de que o domínio ser usado especialmente por contadores públicos ou por pessoas que estariam dentro dos padrões e critérios definidos pelo AICPA. Entretanto, o Going Concern lembra que uma investigação em 68 mil domínios com "cpa" não achou evidências de problemas. O site, ironicamente, afirma:

Meaning there aren’t wild bands of rogue Internet trolls camping CPA domains for the purpose of diluting public trust or worse, offering professional services without a license. Go figure, Internet criminals have better things to do it seems.

Rir é o melhor remédio

Eu costumava pensar que café era uma bebida de adulto. Depois pensava que álcool era uma bebida de adulto. Agora eu finalmente alcancei a iluminação plena e entendi que água é que é a bebida de adulto.

06 julho 2019

Os livros mais vendidos de todos os tempos

A listagem dos livros mais vendidos na história será necessariamente controversa. Há dificuldade nos números, que inclui livros antigos com pouco registro do número de exemplares. Outro aspecto é como considerar o conceito de livro: Harry Potter é um livro ou um conjunto de livros; os livros publicados “copiados” de um terceiro, como a Summa de Pacioli, que foi “copiada” em diferentes idiomas; e as estatísticas das publicações “piratas”; todas são situações onde a mensuração do número pode ser complicada.

O livro Harry Potter e a Pedra Filosofal vendeu 120 milhões de cópias. Já o catalogo da Ikea teve 203 milhões na tiragem de 2017. Mas o catalogo da Ikea não é bem um livro. E quando consideramos a Bíblia e suas derivações torna a listagem mais complicada ainda.

A seguir, uma tentativa de listagem dos livros mais vendidos de todos os tempos:

1 - Citações do Presidente Mao Zedong - O número de unidades vendidas deve estar entre 740 milhões e 5 bilhões de cópias. O ditador chinês, que governou a China entre 1949 até sua morte, publicou aforismos, mas sua tiragem foi comprada pelo estado, não pagou impostos e outros custos.

2 - Dicionário Xinhua - 567 milhões de cópias vendidas - É o dicionário mais “popular”, também vendido na China. Usado na escola primária da China.

3 - Harry Potter - 500 milhões de cópias vendidas para os sete livros. O livro foi escrito há mais de vinte anos e a primeira edição saiu em 1997. Como existe controvérsia dos dois primeiros da listagem, considerar Harry Potter um único livro também é polêmico.

4 - O Senhor dos Anéis - Mais de 100 milhões de cópias vendidas - Livro escrito por Tolkien cujas vendas aumentaram substancialmente com os filmes.

5- Pequeno Príncipe - estimativa de 150 milhões de cópias vendidas. Escrito por Antoine de Saint-EExupéry é também o livro não religioso mais traduzida do mundo: 382 idiomas.

6 - E não sobrou nenhum, de Agatha Christie - 100 milhões de cópias vendidas - É o mistério mais vendido de todos os tempos.

7 - O Código Da Vinci - Cerca de 60 milhões de cópias vendidas. Obra de Dan Brown

8 - Cookbook de Betty Crocker - cerca de 60 milhões decópias vendidas

Parte do sucesso dos livros citados acima ocorreu no final do século XX e início do século XXI. Por este motivo, é bom lembrar do livro “A Cabana do Pai Tomas” que vendeu 3 milhões de exemplares, a maior parte no século XIX.

Adaptado livremente daqui. Dos oito livros mais "vendidos", eu li quatro.

O livro Harry Potter e a Pedra Filosofal vendeu 120 milhões de cópias. Já o catalogo da Ikea teve 203 milhões na tiragem de 2017. Mas o catalogo da Ikea não é bem um livro. E quando consideramos a Bíblia e suas derivações torna a listagem mais complicada ainda.

A seguir, uma tentativa de listagem dos livros mais vendidos de todos os tempos:

1 - Citações do Presidente Mao Zedong - O número de unidades vendidas deve estar entre 740 milhões e 5 bilhões de cópias. O ditador chinês, que governou a China entre 1949 até sua morte, publicou aforismos, mas sua tiragem foi comprada pelo estado, não pagou impostos e outros custos.

2 - Dicionário Xinhua - 567 milhões de cópias vendidas - É o dicionário mais “popular”, também vendido na China. Usado na escola primária da China.

3 - Harry Potter - 500 milhões de cópias vendidas para os sete livros. O livro foi escrito há mais de vinte anos e a primeira edição saiu em 1997. Como existe controvérsia dos dois primeiros da listagem, considerar Harry Potter um único livro também é polêmico.

4 - O Senhor dos Anéis - Mais de 100 milhões de cópias vendidas - Livro escrito por Tolkien cujas vendas aumentaram substancialmente com os filmes.

5- Pequeno Príncipe - estimativa de 150 milhões de cópias vendidas. Escrito por Antoine de Saint-EExupéry é também o livro não religioso mais traduzida do mundo: 382 idiomas.

6 - E não sobrou nenhum, de Agatha Christie - 100 milhões de cópias vendidas - É o mistério mais vendido de todos os tempos.

7 - O Código Da Vinci - Cerca de 60 milhões de cópias vendidas. Obra de Dan Brown

8 - Cookbook de Betty Crocker - cerca de 60 milhões decópias vendidas

Parte do sucesso dos livros citados acima ocorreu no final do século XX e início do século XXI. Por este motivo, é bom lembrar do livro “A Cabana do Pai Tomas” que vendeu 3 milhões de exemplares, a maior parte no século XIX.

Adaptado livremente daqui. Dos oito livros mais "vendidos", eu li quatro.

05 julho 2019

O dinheiro acabou

Alguns economistas têm criticado a “obsessão” pelo ajuste fiscal em decorrência dos seus efeitos deletérios sobre a atividade econômica, enquanto outros defendem a expansão do investimento em infraestrutura.

A atual política fiscal, no entanto, não é o resultado de uma escolha. O dinheiro acabou e o governo não pode aumentar o gasto público.

O problema decorre de muitas leis que tornaram compulsórios diversos gastos públicos, há décadas crescendo bem mais do que a renda nacional. Faz tempo, a receita corrente não é suficiente para pagar esses gastos, quanto mais as despesas discricionárias necessárias para manter a máquina pública funcionando.

Nos últimos anos, as contas foram pagas com receitas extraordinárias, como a devolução dos empréstimos ao BNDES ou o lucro do Banco Central. Essas fontes, no entanto, estão secando. A saída seria o governo se endividar para pagar as despesas correntes, mas isso é proibido por artigo da Constituição —a regra de ouro.

Por essa razão, o governo teve que pedir ao Congresso a aprovação de crédito suplementar, uma saída que pode ser até legal, mas fere o espírito da regra de ouro. A alternativa seria interromper pagamentos de programas como o Bolsa Família, o que ninguém tem defendido.

Não há mais nada que o governo possa fazer na seara fiscal sem a revisão das leis em vigor.

Parece inevitável rever a regra de ouro. Essa mudança deveria ser acompanhada de medidas adicionais que interrompam o aumento descontrolado do gasto público, a começar pela reforma da Previdência.

Caso o governo tenha que se endividar para pagar despesas correntes, a contrapartida deveria ser proibir o aumento dos gastos com os servidores, a concessão de subsídios e a criação de despesas obrigatórias.

Sem essas medidas, o crescimento da dívida pública levará ao aumento da inflação e das taxas de juros, prejudicando ainda mais a economia.

A expansão da infraestrutura seria bem-vinda, mas vale lembrar alguns dos projetos do governo dos últimos 15 anos, como as refinarias ineficientes, o trem-bala e Angra 3. Se é para fazer isso, melhor mesmo não ter dinheiro para gastar.

O poder público foi, inclusive, incapaz de propor projetos executivos detalhados, o que resultou em falta de previsibilidade das contrapartidas ambientais e sociais, comprometendo severamente os planos iniciais.

Quem vai investir em infraestrutura depois dos seguidos problemas emBelo Monte e no linhão de energia em Roraima? Houve ainda as desastrosas intervenções nos setores de óleo e gás e de energia.

Não faltam recursos privados para os investimentos; faltam, isso sim, regras previsíveis, o que é fácil de diagnosticar, mas difícil de resolver. Os problemas são mais sutis do que sugerem as frases de efeito.

Marcos Lisboa

Presidente do Insper, ex-secretário de Política Econômica do Ministério da Fazenda (2003-2005) e doutor em economia.

A atual política fiscal, no entanto, não é o resultado de uma escolha. O dinheiro acabou e o governo não pode aumentar o gasto público.

O problema decorre de muitas leis que tornaram compulsórios diversos gastos públicos, há décadas crescendo bem mais do que a renda nacional. Faz tempo, a receita corrente não é suficiente para pagar esses gastos, quanto mais as despesas discricionárias necessárias para manter a máquina pública funcionando.

Nos últimos anos, as contas foram pagas com receitas extraordinárias, como a devolução dos empréstimos ao BNDES ou o lucro do Banco Central. Essas fontes, no entanto, estão secando. A saída seria o governo se endividar para pagar as despesas correntes, mas isso é proibido por artigo da Constituição —a regra de ouro.

Por essa razão, o governo teve que pedir ao Congresso a aprovação de crédito suplementar, uma saída que pode ser até legal, mas fere o espírito da regra de ouro. A alternativa seria interromper pagamentos de programas como o Bolsa Família, o que ninguém tem defendido.

Não há mais nada que o governo possa fazer na seara fiscal sem a revisão das leis em vigor.

Parece inevitável rever a regra de ouro. Essa mudança deveria ser acompanhada de medidas adicionais que interrompam o aumento descontrolado do gasto público, a começar pela reforma da Previdência.

Caso o governo tenha que se endividar para pagar despesas correntes, a contrapartida deveria ser proibir o aumento dos gastos com os servidores, a concessão de subsídios e a criação de despesas obrigatórias.

Sem essas medidas, o crescimento da dívida pública levará ao aumento da inflação e das taxas de juros, prejudicando ainda mais a economia.

A expansão da infraestrutura seria bem-vinda, mas vale lembrar alguns dos projetos do governo dos últimos 15 anos, como as refinarias ineficientes, o trem-bala e Angra 3. Se é para fazer isso, melhor mesmo não ter dinheiro para gastar.

O poder público foi, inclusive, incapaz de propor projetos executivos detalhados, o que resultou em falta de previsibilidade das contrapartidas ambientais e sociais, comprometendo severamente os planos iniciais.

Quem vai investir em infraestrutura depois dos seguidos problemas emBelo Monte e no linhão de energia em Roraima? Houve ainda as desastrosas intervenções nos setores de óleo e gás e de energia.

Não faltam recursos privados para os investimentos; faltam, isso sim, regras previsíveis, o que é fácil de diagnosticar, mas difícil de resolver. Os problemas são mais sutis do que sugerem as frases de efeito.

Marcos Lisboa

Presidente do Insper, ex-secretário de Política Econômica do Ministério da Fazenda (2003-2005) e doutor em economia.

Copa do mundo de futebol feminino

The Women's World Cup is drawing record audiences. More skilful play and new sponsorship deals are two reasons why.

Fonte: aqui

Bancos Europeus

Na internet, dois gráficos sobre a cotação das ações. O primeiro é o índice Stoxx 600 Banks:

A partir de 2015 o índice das instituições financeiras começaram a cair. O nível mais baixo ocorreu quando tivemos o Brexit ou a saída do Reino Unido da Comunidade Europeia. Em 2018, a crise com o Deutsche Bank não deixou o índice ter uma recuperação.

Entretanto, uma análise histórica do preço da ação da instituição alemã mostra que o problema é muito anterior:

Na crise financeira a ações do Deutsche caíram de um teto de 120 Euros para 20 Euros. Atualmente está um pouco abaixo dos 7 euros. Mesmo com a volta do lucro, as investigações sobre fraude fiscal e os problemas de controle interno não ajudam.

A partir de 2015 o índice das instituições financeiras começaram a cair. O nível mais baixo ocorreu quando tivemos o Brexit ou a saída do Reino Unido da Comunidade Europeia. Em 2018, a crise com o Deutsche Bank não deixou o índice ter uma recuperação.

Entretanto, uma análise histórica do preço da ação da instituição alemã mostra que o problema é muito anterior:

04 julho 2019

Liberdade econômica

A medida provisório 881, que trata da liberdade econômica, está sendo ampliada na tramitação no Congresso Nacional. Há uma pressão para simplificação do e-Social - ou sua extinção. A comissão mista deve-se reunir na terça feira, as 14 horas, mas o repórter do jornal Valor afirma que conheceu o parecer do relator.

Segundo o jornal, outra alteração seria a proibição “que conselhos, sociedades, associações e sindicatos profissionais, estabeleçam, por autorregulação, valores mínimos e máximos que serão cobrados por profissionais liberais. Isto atingiria diretamente o CFC, por exemplo.

Mas uma vez que a MP recebeu mais de 300 emendas, talvez o consenso não seja tão fácil assim.

Segundo o jornal, outra alteração seria a proibição “que conselhos, sociedades, associações e sindicatos profissionais, estabeleçam, por autorregulação, valores mínimos e máximos que serão cobrados por profissionais liberais. Isto atingiria diretamente o CFC, por exemplo.

Mas uma vez que a MP recebeu mais de 300 emendas, talvez o consenso não seja tão fácil assim.

Custo do off-line

O desenvolvimento da internet trouxe novas oportunidades e receitas. Mas criou um problema: a dependência de estar on-line. Quando o consumidor deixa de ter acesso ao site de uma empresa, isto pode representar perda de receita. E o custo da interrupção aumentou nos últimos anos.

Um cálculo feito usando o ABC, em 2010, 2013 e 2016, mostrou o custo por minuto de um data center com problema. Eis o resultado:

Se em 2010 o custo por minuto do inatividade era de 5 mil dólares, em 2016 este valor aumento quase 60%. Como algumas da paradas foram superiores a um minuto, o custo total é muito expressivo. Uma interrupção média custa algo em torno de 740 mil de dólares ou US$9000 x 1hora e 20 minutos.

Como os mercados on-line são cada vez mais representativos, o risco de uma interrupção e o seu custo são relevantes.

Leia mais aqui

Um cálculo feito usando o ABC, em 2010, 2013 e 2016, mostrou o custo por minuto de um data center com problema. Eis o resultado:

Se em 2010 o custo por minuto do inatividade era de 5 mil dólares, em 2016 este valor aumento quase 60%. Como algumas da paradas foram superiores a um minuto, o custo total é muito expressivo. Uma interrupção média custa algo em torno de 740 mil de dólares ou US$9000 x 1hora e 20 minutos.

Como os mercados on-line são cada vez mais representativos, o risco de uma interrupção e o seu custo são relevantes.

Leia mais aqui

Desonestidade

Como as pessoas reagem quando acham uma carteira de alguém? A reação varia conforme o local e também o conteúdo da carteira explica o comportamento das pessoas. Um estudo, publicado na Science tratou deste assunto. Alain Cohn, Michael André Marechal, David Tannenbaum e Christian Lukas usaram assistentes que “acharam” uma carteira em 355 cidades de 40 países do mundo. E verificaram a honestidade das pessoas. No total foram 17 mil carteiras, a um custo de meio milhão de dólares.

Em cada carteira tinham listas de compras, em língua local, e cartões com o nome da pessoa que perdeu (incluindo o e-mail). Em algumas carteiras, nenhum dinheiro. Em outras, cerca de 13 dólares em moeda local. Os assistentes entregaram as carteiras para funcionários de bancos, hotéis, agências dos correios, museus e delegacias de polícia. Afirmavam que tinham encontrado a carteira e estavam com pressa para entrar em contato com o dono. E deram a responsabilidade para que recebeu a carteira. Nas carteiras sem dinheiro, o índice de devolução foi de 40%. Nas carteiras com dinheiro, a devolução foi de 51%.

Este índice variou conforme o país: na Dinamarca o percentual de devolução foi de 82%, mas nos Estados Unidos foi de 57%.

Além disto, os pesquisadores também aumentaram a quantidade de dinheiro em três países (EUA, RU e Polônia) e uma grande surpresa: o percentual de devolução aumentou, em lugar de diminuir. Pela teoria formulada por Gary Becker deveria ser o oposto, já que o comportamento desonesto é uma especie de análise do custo benefício.

Outro fato interessante: algumas carteiras não tinham dinheiro, mas tinha um chave. A presença da chave também aumentou o índice de devolução.

O gráfico mostra em amarelo o percentual de devolução com a carteira sem dinheiro; de vermelho, com dinheiro. Países escandinavos são honestos; China foi o mais desonesto. O Brasil ficou em 26o lugar; nada mal, para quem tem a fama de ser um país dos desonestos.

Um estudo realizado no Brasil mostrou também que os grupos sociais podem afetar esta honestidade das pessoas. Trata-se da tese de doutorado de Mariana Bonfim.

Fonte: Civic honesty around the globe. Science 20 JUN 2019. DOI: 10.1126/science.aau8712

Em cada carteira tinham listas de compras, em língua local, e cartões com o nome da pessoa que perdeu (incluindo o e-mail). Em algumas carteiras, nenhum dinheiro. Em outras, cerca de 13 dólares em moeda local. Os assistentes entregaram as carteiras para funcionários de bancos, hotéis, agências dos correios, museus e delegacias de polícia. Afirmavam que tinham encontrado a carteira e estavam com pressa para entrar em contato com o dono. E deram a responsabilidade para que recebeu a carteira. Nas carteiras sem dinheiro, o índice de devolução foi de 40%. Nas carteiras com dinheiro, a devolução foi de 51%.

Este índice variou conforme o país: na Dinamarca o percentual de devolução foi de 82%, mas nos Estados Unidos foi de 57%.

Além disto, os pesquisadores também aumentaram a quantidade de dinheiro em três países (EUA, RU e Polônia) e uma grande surpresa: o percentual de devolução aumentou, em lugar de diminuir. Pela teoria formulada por Gary Becker deveria ser o oposto, já que o comportamento desonesto é uma especie de análise do custo benefício.

Outro fato interessante: algumas carteiras não tinham dinheiro, mas tinha um chave. A presença da chave também aumentou o índice de devolução.